机构名称:

¥ 2.0

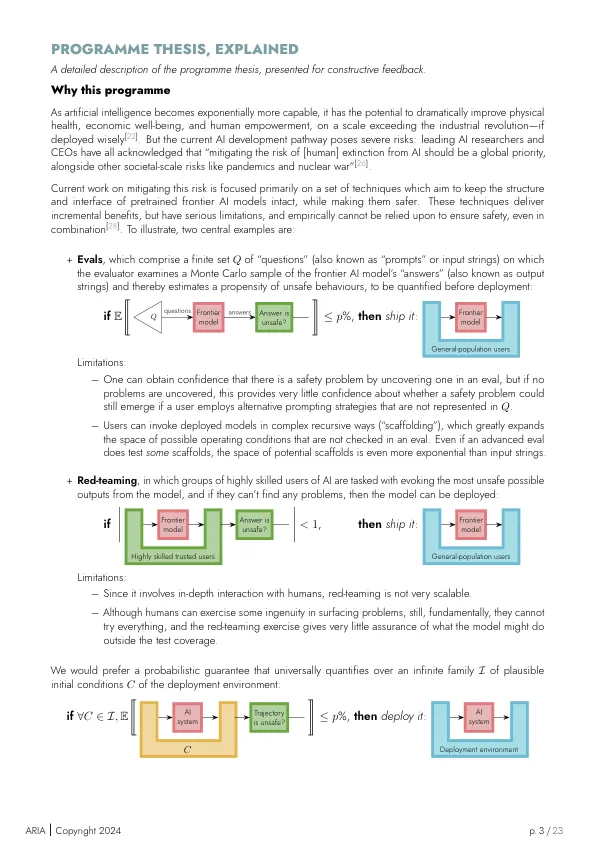

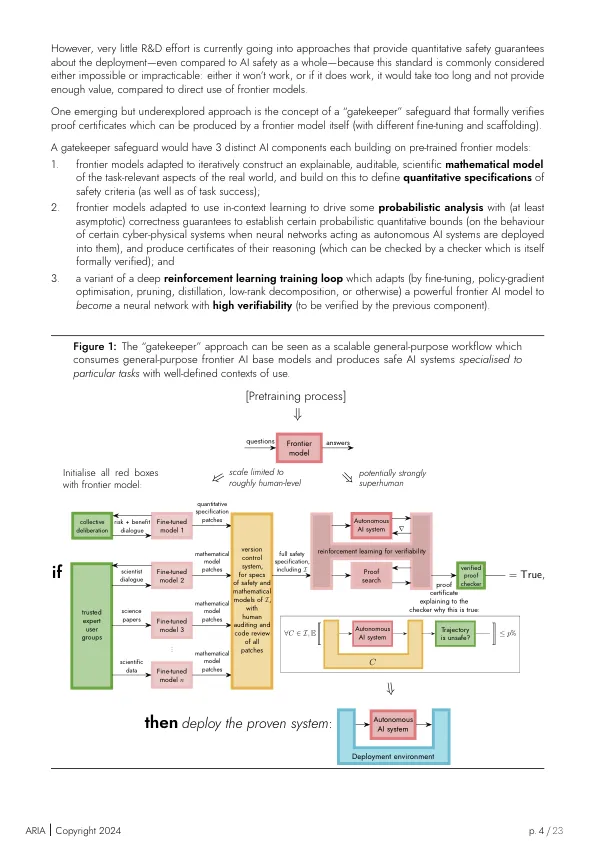

为了做出这样的证明,必须首先定义有关AI系统的规范(理想地将集体审议过程中的意见与相关利益相关者有关适当的风险阈值和定义进行了相关的利益相关者)。为了定义作为现实世界网络物理系统的AI系统的安全规范,必须定义部署系统动态和环境动态的数学模型。规范可以对环境中发生的情况提出要求(例如某种正式定义的“危害”并不是出于高概率而发生的),而不是正式的规格,仅指AI系统本身的输入和输出之间的关系(这足以定义某些非平地属性,例如“对抗性鲁棒性”,但不是任何安全性)。为了将其视为部署环境中可能发生的事情的“基础真理”,以作为系统认证的信任根源,必须由人类团队审核这些数学模型,因此必须既可以理解它们的模型语言,又可以理解为正式方法。

保护AI:构建保证安全

主要关键词