机构名称:

¥ 1.0

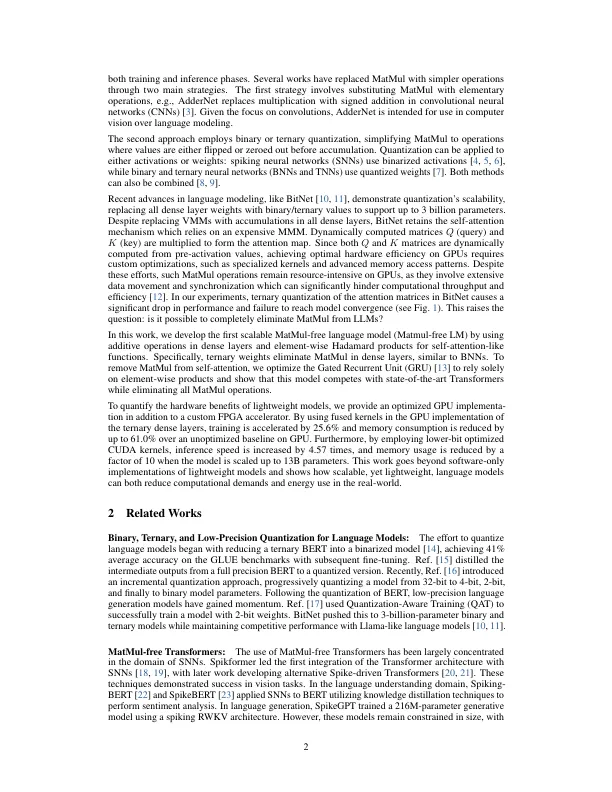

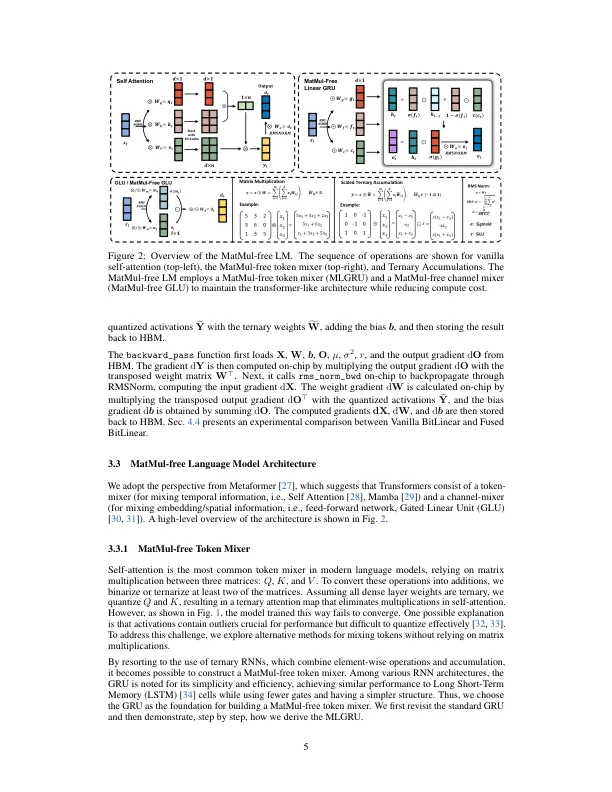

矩阵乘法 (MatMul) 通常占据大型语言模型 (LLM) 总体计算成本的主导地位。随着 LLM 扩展到更大的嵌入维度和上下文长度,这一成本只会增长。在本研究中,我们证明了 MatMul 操作可以完全从 LLM 中消除,同时在十亿参数规模下保持强劲性能。我们的实验表明,我们提出的无 MatMul 模型的性能与最先进的 Transformer 相当,后者在推理过程中需要更大的内存,并且参数规模至少高达 27 亿。我们研究了缩放规律,发现我们的无 MatMul 模型与全精度 Transformer 之间的性能差距随着模型规模的增加而缩小。我们还提供了该模型的 GPU 高效实现,与未优化的基准相比,在训练期间可将内存使用量降低高达 61%。通过在推理过程中使用优化的内核,与未优化的模型相比,我们的模型的内存消耗可减少 10 倍以上。为了准确量化我们架构的效率,我们在 FPGA 上构建了一个定制的硬件解决方案,该解决方案充分利用了 GPU 无法处理的轻量级运算。我们以 13W 的功耗处理了数十亿参数规模的模型,其吞吐量远超人类可读的吞吐量,使 LLM 的效率更接近人脑的水平。这项工作不仅展示了 LLM 在保持高效性能的同时可以精简到何种程度,还指出了未来加速器在处理下一代轻量级 LLM 时应针对哪些类型的运算进行优化。我们的代码实现可在 https://github.com/ridgerchu/matmulfreellm 获取。

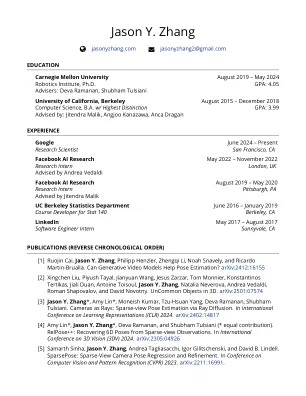

可扩展的无 MatMul 语言建模 - Yu Zhang

主要关键词