机构名称:

¥ 1.0

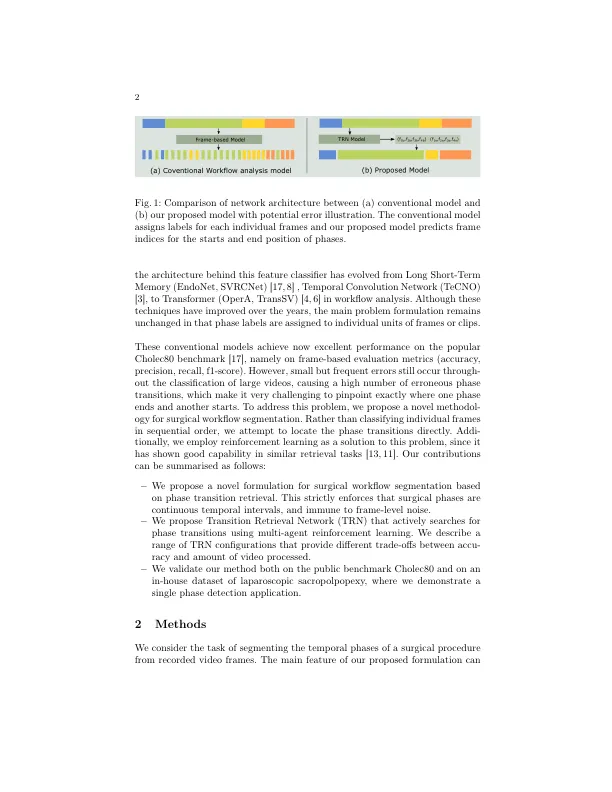

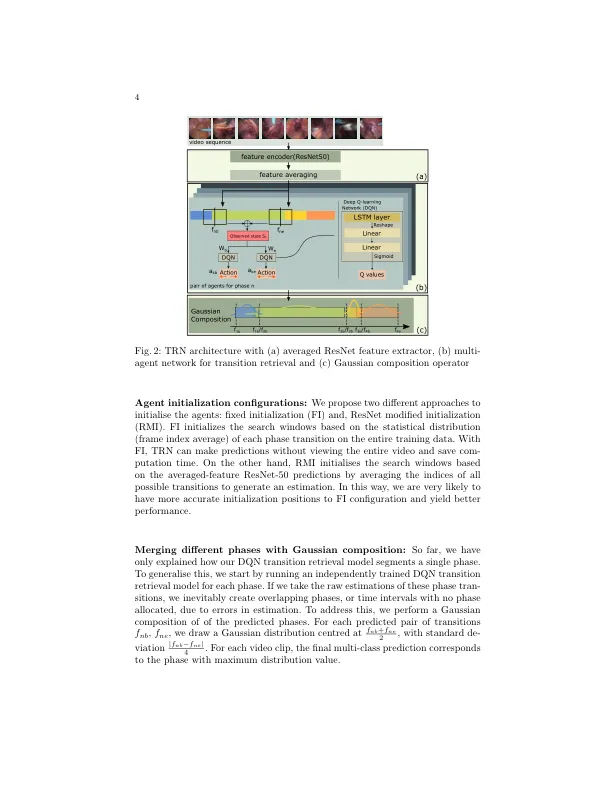

摘要。在微创手术中,视频分析的手术工作流程分割是一个经过深入研究的主题。传统的AP-PRACH将其定义为多类分类问题,其中各个视频帧被归因于手术期标签。我们引入了一种新颖的加固学习公式,以用于离线相过渡检索。我们没有试图对每个视频框架进行分类,而是确定每个相变的时间框架。通过构造,我们的模型不会产生虚假和嘈杂的相变,而是连续的相位块。我们研究了该模型的两种不同配置。第一个不需要在视频中处理所有框架(在2个不同的应用程序中仅<60%和<20%的帧),而在最先进的准确性下略微产生结果。第二个配置处理所有视频帧,并以可比的计算成本优于最先进的框架。我们将方法与公共数据集Cholec80上的最近基于框架的最高框架方法Tecno和Trans-Svnet进行了比较,也将腹腔镜sapocococopopopopopopopopopopexy的内部数据集进行了比较。我们同时执行基于帧的(准确性,精度,重新调用和F1得分),也可以对我们的算法进行基于事件的(事件比率)评估。

使用加固学习的手术期转变