机构名称:

¥ 1.0

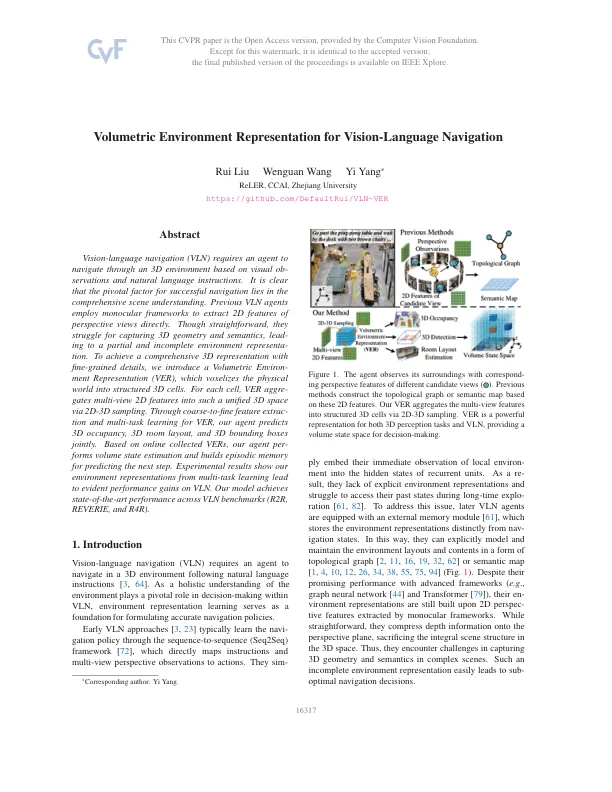

Vision语言导航(VLN)要求代理在基于视觉观察和自然语言说明的3D环境中导航。很明显,成功导航的关键因素在于全面的场景理解。以前的VLN代理使用单眼框架直接提取透视视图的2D特征。虽然很简单,但他们为捕获3D几何和语义而努力,导致部分不完整的环境代表。为了实现具有细粒细节的全面3D表示,我们引入了体积环境(VER),将物理世界脱氧于结构化的3D细胞中。对于每个单元格,通过2D-3D采样将多视图2D特征归纳到如此统一的3D空间中。通过对VER的粗略到纤维特征进行推断和多任务学习,我们的代理人可以共同预测3D占用率,3D房间布局和3D边界框。基于在线收集的vers,我们的代理构成了体积状态估计,并构建情节内存以预测下一步。实验结果表明,我们从多任务学习的环境表示导致了VLN的可观绩效提高。我们的模型在VLN基准(R2R,Reverie和R4R)之间实现了最新的性能。

视觉导航的体积环境表示

主要关键词