机构名称:

¥ 1.0

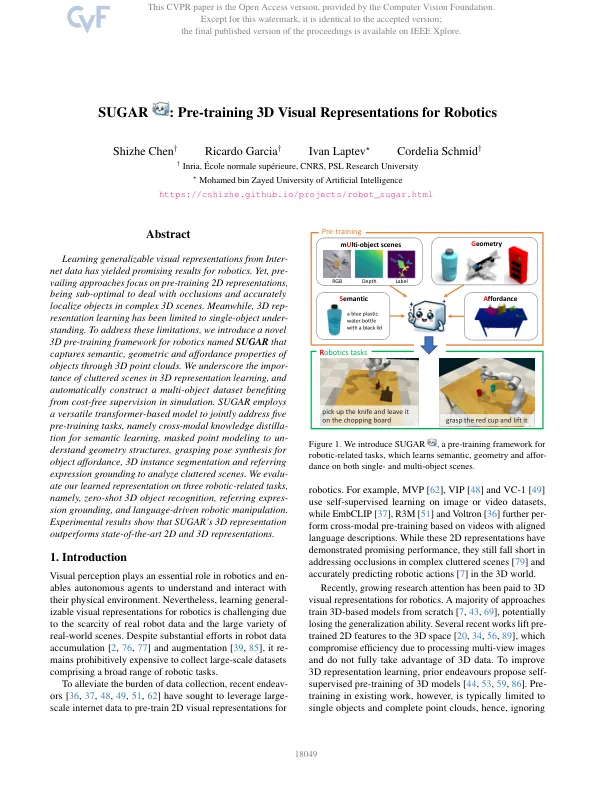

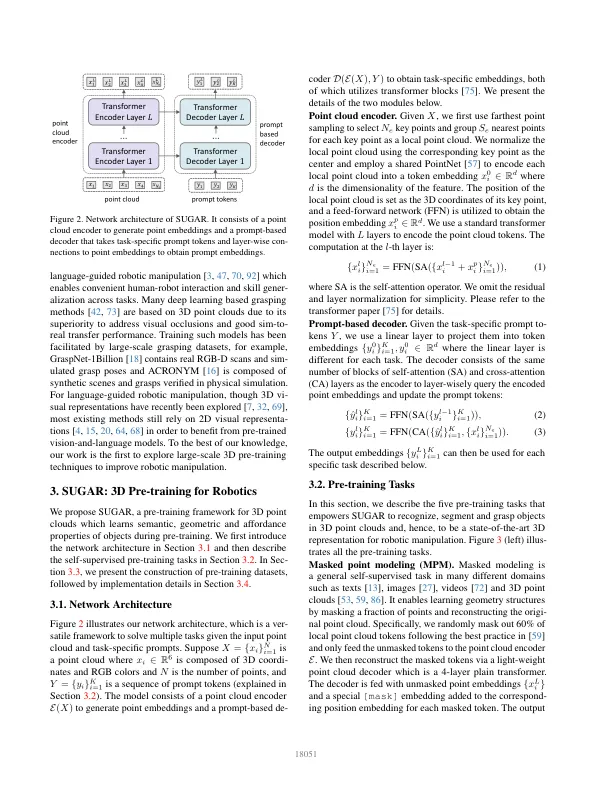

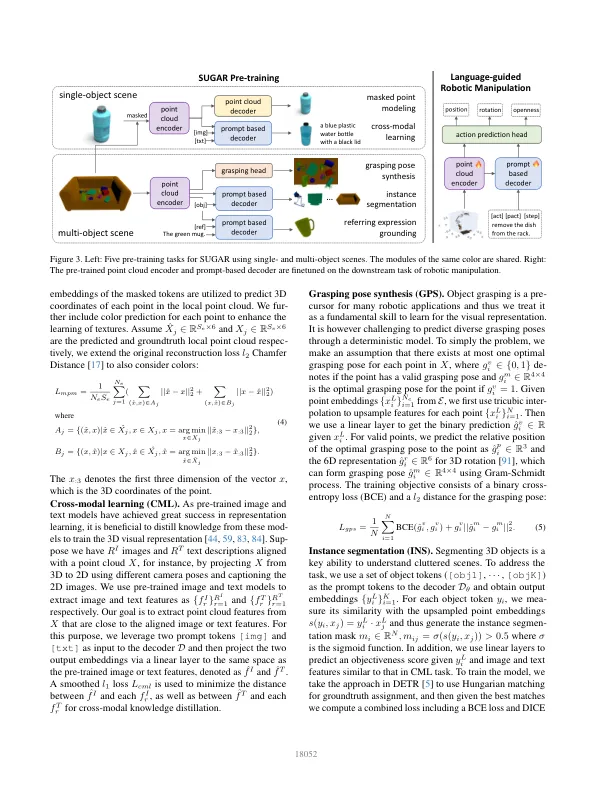

从网络数据中学习可概括的视觉表示已为机器人技术带来了令人鼓舞的结果。然而,预循环方法着眼于预训练2D表示,是应对闭塞的优势,并在复杂的3D场景中准确地将对象定位。同时,3D代表学习仅限于单对象。为了解决这些局限性,我们引入了一个名为Sugar的机器人技术的新型3D预训练框架,该框架通过3D点云捕获对象的语义,几何和负担性能。我们强调了3D表示学习中混乱场景的重要性,并自动构建一个受益于模拟中无需成本监督的多对象数据集。Sugar采用一种多功能变压器的模型来共同解决五个预训练任务,即用于语义学习的跨模式知识蒸馏,以掩盖点建模,以取消几何结构,掌握姿势合成以进行对象负担,3D实例分割和引用表达地面以分析杂乱无章的场景。我们对三个与机器人相关的任务进行了学习的代表,即零射击3D对象识别,引用凸起的接地和语言驱动的机器人操作。实验结果表明,糖的3D表示优于最先进的2D和3D表示。

糖:机器人技术的预训练3D视觉表示

主要关键词