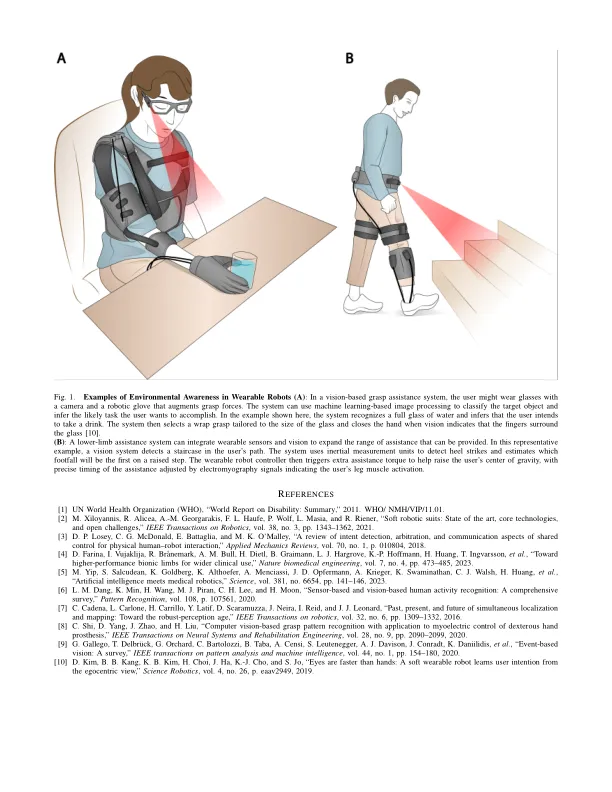

现在,我们可以想象一个未来,世界上有残疾人生活的十亿人中有许多人可以在不损害的情况下度过自己的日常生活,这要归功于可穿戴的机器人[1]。这些设备,包括外骨骼和假肢,有可能革新我们协助个人受损的方式。对于上限,可穿戴设备可以在操纵任务中提供抓地力并掌握稳定性,对于下limb,它们可以改善步态模式并减少能量消耗。这些系统的发展激增,最初的工作主要集中在机械设计,人体的界面以及感知用户的四肢上。这产生了有效的系统,以帮助水平地形上的基本抓地任务和运动[2]。扩展到更复杂的任务和更高级别的援助需要推断用户的意图。例如,辅助手套需要知道用户要掌握特定对象以执行特定的任务,然后将掌握类型和手指跨度调整为该对象和任务。对于腿部外骨骼或假肢,该系统需要检测到用户计划上台或穿越湿的人行道,因此可以调整联合扭矩以最大程度地提高援助和稳定性。目前,最流行的下LIMB用户意图的方法是基于用户的运动学信息的惯性传感器。例如,可以使用脚上的惯性测量单元估算脚跟罢工。推断用户意图的另一种方法是利用神经肌肉界面,例如肌电图(EMG)。基于先前步态周期的控制策略可以通过假设用户打算采用类似的运动模式来预测当前的步态周期。这种方法可以测量肌肉电信号来推断运动激活。例如,可以使用从身体部位到肢体截肢的EMG信号来推断缺失的肢体的故意作用以控制活跃的上LIMB假体。基于这些生物学信号的接口和用户的行为提供了对用户内部状态的估计,但是可以解码的信息量仅限于简单的推论,例如通过关节角度传感检测步行速度的变化或用EMG脉冲触发假肢闭合[3]。这将可穿戴设备限制在少量任务中,并且用户通常将控制被认为是复杂而不自然的[4]。这是较高的上限上限假体遗弃率相对较大的原因之一。要扩大任务范围和援助质量,可穿戴机器人必须使用有关发生运动动作的上下文的信息。例如,通过广泛的机器学习,腿部肌肉上的EMG传感器可以检测与水平运动和上升楼梯之间过渡相关的肌肉活动的变化。专门基于EMG,过渡过程中的分类误差比稳态期间的分类误差高四倍[5]。另一方面,上下文的知识(楼梯的位置和步行方向)将允许前方的几个步骤和更高的准确性。计算机视觉可以在获取有关环境和任务上下文的信息中发挥核心作用。视觉提供了有关用户及其周围环境的丰富,直接和可解释的信息,如人类的视觉能力所证明。最近基于视力的人类姿势估计和行动分类技术可以提供有关人类行为的广泛信息[6]。驾驶员和行人意图预测可能是基准的一个很好的例子。感应周围环境是一个充分探索的机器人问题,可以通过对象/场景识别以及同时定位和映射等技术来实现[7]。将视觉行为与上下文信息合并以推断人们的意图仍处于最早的阶段[8],并提出了未解决的挑战。一种通用方法可以使用包括

现实世界的可穿戴机器人需要视觉

主要关键词