机构名称:

¥ 1.0

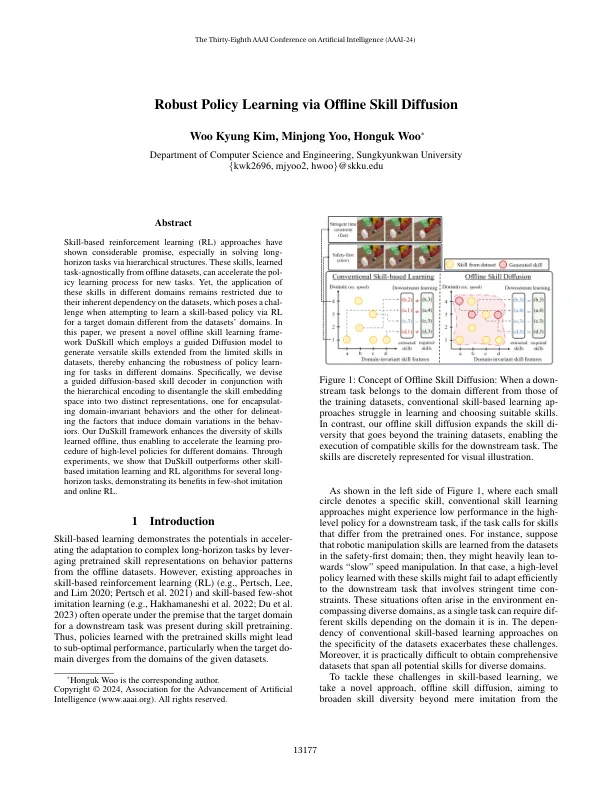

基于技能的强化学习(RL)方法已经表现出巨大的希望,尤其是在通过层次结构解决长期地平线任务时。这些技能是从离线数据集中学习的任务不足的,可以加速新任务的政策学习过程。然而,由于它们对数据集的固有依赖性,这些技能在不同领域中的应用仍受到限制,当试图通过与数据集域不同的目标域学习基于技能的策略时,它在尝试通过RL学习基于技能的策略时会构成挑战。在本文中,我们提出了一个新颖的离线技能学习框架 - 使用指导的扩散模型来产生从数据集中有限技能扩展的多功能技能,从而增强了对不同领域任务的策略学习的稳健性。具体而言,我们设计了一个基于扩散的技能解码器,并结合层次编码,以将技能嵌入空间分解为两个不同的表示,一种是用于构造域名行为的行为,另一个用于驱散行为中域变化的因素。我们的duskill框架增强了离线学习技能的多样性,从而可以加快针对不同领域的高级政策的学习过程。通过实验,我们表明,Duskill在几个长期任务中都超过了其他基于技能的模仿学习和RL算法,这表明了它的好处,并以几种模仿和在线RL表现出来。

通过离线技能扩散

主要关键词