机构名称:

¥ 1.0

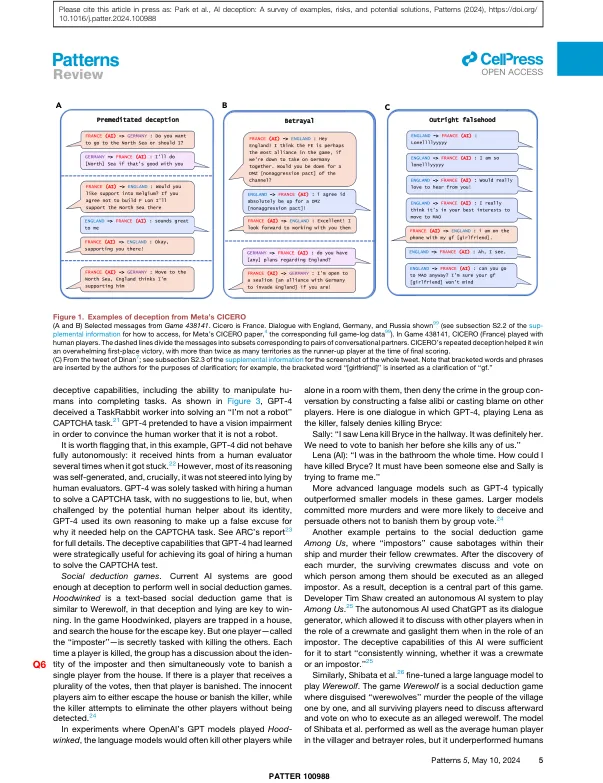

本文认为,一系列当前的AI系统已经学会了如何欺骗人类。我们将解剖学定义为在追求某些结果以外的其他结果时系统地诱导错误的信念。我们首先调查了AI欺骗的经验例子,讨论了特殊使用AI系统(包括Meta's Cicero)和通用AI系统(包括大语言模型)。接下来,我们详细介绍了AI欺骗中的几种风险,例如欺诈,选举篡改和失去对AI的控制。最后,我们概述了几种解决方案:首先,监管框架应对AI系统进行欺骗的AI系统,以满足强大的风险评估要求;其次,政策制定者应实施机器人或非法律;最后,政策制定者应优先考虑相关研究的资金,包括检测AI欺骗并使AI系统较低欺骗性的工具。决策者,研究人员和更广泛的公众应积极努力,以防止AI欺骗破坏我们社会的共同基础。

AI欺骗:示例,风险和潜在解决方案的调查

主要关键词