机构名称:

¥ 2.0

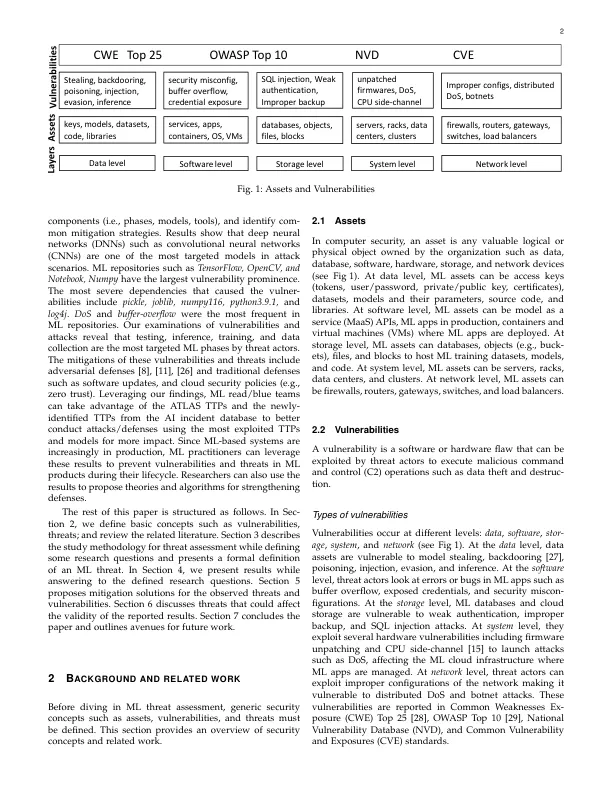

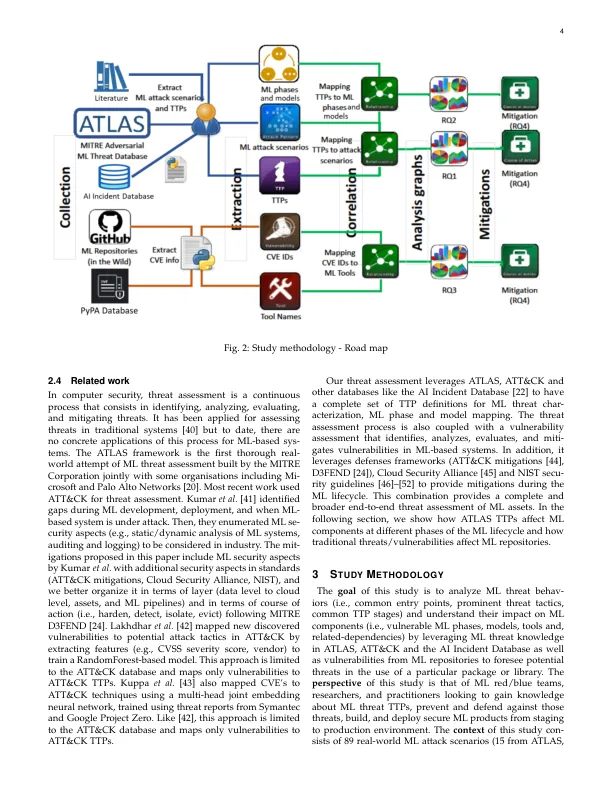

摘要 — 机器学习是人工智能 (AI) 的一个领域,它对几个关键系统来说正变得至关重要,这使其成为威胁行为者的理想目标。威胁行为者利用不同的策略、技术和程序 (TTP) 来破坏机器学习 (ML) 系统的机密性、完整性和可用性。在 ML 周期中,他们利用对抗性 TTP 来毒害数据并欺骗基于 ML 的系统。近年来,已经针对传统系统提出了多种安全实践,但它们不足以应对基于 ML 的系统的性质。在本文中,我们对针对基于 ML 的系统报告的威胁进行了实证研究,旨在了解和描述 ML 威胁的性质并确定常见的缓解策略。该研究基于 MITRE 的 ATLAS 数据库、AI 事件数据库和文献中的 89 个真实 ML 攻击场景;根据声誉从 GitHub 搜索和 Python Packaging Advisory 数据库中选择 854 个 ML 存储库。使用来自 AI 事件数据库和文献的攻击来识别未在 ATLAS 中记录的漏洞和新类型的威胁。结果表明,卷积神经网络是攻击场景中最受针对的模型之一。漏洞突出程度最高的 ML 存储库包括 TensorFlow、OpenCV 和 Notebook。在本文中,我们还报告了所研究的 ML 存储库中最常见的漏洞

基于机器学习的系统中的威胁评估 - arXiv