XiaoMi-AI文件搜索系统

World File Search SystemP.S.G.技术学院(自主)

- 未安排在该计划开始之前毕业,并且必须在实习结束后返回印度后至少恢复其学术课程(本科或硕士)至少一个学期或四分之一。- 具有很强的学业成绩记录。- 按照列表中指定的满足所选实验室的要求。- 有兴趣在京都大学寻求博士学位课程。•KU -Star计划的参与者必须同意: - 及时申请适当的签证以及时进入日本。- 在该计划期间,请留在京都大学指定和提供的住宿。- 参加入学和所有必需的会议,活动和文化活动,例如通过京都大学实习计划办公室组织的日语课程。- 在一个参与的实验室中进行30-60天的高级研究项目。- 充分参加分配给他们的实验室的学术活动,参加任何相关的研究研讨会和研讨会。- 在计划结束时准备有关其工作的海报演示文稿。- 首先,将其在计划期间工作中从其工作中产生的任何知识产权分配给其主管。- 提供有关KU -Star计划的反馈。- 同意在该计划期间由京都大学拍摄,并授予大学发布照片的权利。- 为京都大学提供与媒体和公共关系有关的请求。- 在该计划的整个过程中出席京都大学。(鉴于该计划的密集性,参与者将无法在计划期间从事其他工作或学习。不打算在整个计划期间不打算出席京都大学的学生的申请。)

实习飞行软件、计算机视觉和人工智能 瑞士苏黎世 公司:Daedalean 是一家总部位于苏黎世的初创公司,由前谷歌和 SpaceX 工程师创立,他们希望在未来十年内彻底改变城市航空旅行。我们结合计算机视觉、深度学习和机器人技术,为飞机开发最高级别的自主性(5 级),特别是您可能在媒体上看到的电动垂直起降飞机。如果您加入我们的实习,您将有机会与经验丰富的工程师一起工作,他们来自 CERN、NVIDIA、伦敦帝国理工学院或……自治系统实验室本身。您将构建塑造我们未来的尖端技术。最重要的是,我们还提供在瑞士阿尔卑斯山试飞期间与我们的飞行员一起飞行的机会。项目:不同的团队都提供机会。我们希望更多地了解您,以及我们如何让您的实习成为双方宝贵的经历。告诉我们您一直在做什么,以及您想在我们的团队中从事什么工作。它与深度学习有关吗?状态估计?运动规划?计算机视觉?或者其他什么?向我们展示您的热情所在。如果我们可以在您想要从事的领域提供指导和有趣的机会,我们将一起敲定细节。资格:强大的动手 C++ 经过验证的解决问题的能力如何申请:将您的简历/履历发送至 careers@daedalean.ai 。电话

实习飞行软件、计算机视觉和人工智能瑞士苏黎世公司:Daedalean 是一家总部位于苏黎世的初创公司,由前谷歌和 SpaceX 工程师创立,他们希望在未来十年内彻底改变城市航空旅行。我们结合计算机视觉、深度学习和机器人技术,为飞机开发最高级别的自主性(5 级),特别是您可能在媒体上看到的电动垂直起降飞机。如果您加入我们的实习,您将有机会与经验丰富的工程师一起工作,他们来自 CERN、NVIDIA、伦敦帝国理工学院或……自治系统实验室本身。您将构建塑造我们未来的尖端技术。最重要的是,我们还提供在瑞士阿尔卑斯山试飞期间加入我们飞行员的机会。项目:不同团队提供机会。我们想更多地了解您,以及如何让您的实习成为双方宝贵的经历。告诉我们你一直在做什么,以及你想在我们的团队中从事什么工作。它与深度学习有关吗?状态估计?运动规划?计算机视觉?或者别的什么?向我们展示你的热情所在。如果我们可以在你想从事的领域提供指导和有趣的机会,我们将一起敲定细节。资格: 强大的动手 C++ 证明解决问题的能力 如何申请: 将您的简历/履历发送至 careers@daedalean.ai 。请告诉我们一些关于您自己的信息,为什么您认为自己适合我们以及为什么我们适合您。

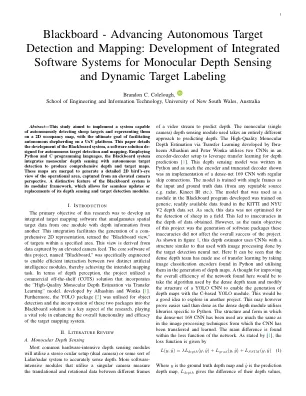

黑板 - 前进的自主目标检测和映射:开发用于单眼深度感应和动态tar

摘要 - 该研究旨在实施能够自主检测绵羊目标并在2D占用图上代表它们的系统,其最终目标是促进在UXV平台上自主牧羊。本文详细介绍了Blackboard System的开发,Blackboard System是一种用于自动目标检测和映射的软件解决方案。使用Python和C编程语言,Blackboard系统将单眼深度感测与自主目标检测,以产生全面的深度和目标图。这些地图是合并的,以产生从高架相机的角度捕获的操作区域的详细的2D鸟视图。黑板系统的独特功能是其模块化框架,它允许无缝更新或更换其深度传感和目标检测模块。

Agrirobot获得资金以加速自主农业安全软件的发展。

lizzie blythe lizzie.bly@ederalab.co.uk初级客户经理+44(0)20 805 850 18 Sam Salzman sam.salzman@ederalab.co.uk.co.uk International PR Executive +44(0)7848 698 867

人工智能和自主的观点...

©编辑(如果适用)和作者,根据Springer Nature Switzerland AG 2024的独家许可,这项工作将获得版权。所有权利都是由出版商唯一的,仅由材料的全部或一部分授权的,尤其是翻译,重新使用,插图,朗诵,广播,在微胶片上或以任何其他物理方式复制,以任何其他物理方式复制,以及以任何其他物理方式复制,以及传输或检索,传输和检索,电子适应性,计算机软件,或通过类似的方法,或者是类似的方法,或者现在是相似的方法,或者现在是这些方法。使用一般描述性名称,注册名称,商标,服务标记等。在本出版物中,即使在没有具体陈述的情况下,这种名称也不意味着免于相关的保护法律和法规,因此可以免费使用。出版商,作者和编辑可以肯定地假设本书中的建议和信息在出版之日被认为是真实而准确的。就本文包含的材料或可能已犯的任何错误或遗漏而言,出版商,作者或编辑都没有提供任何明示或暗示的保修。出版商在已发表的地图和机构隶属关系中的管辖权索赔方面保持中立。

软件工程 - 自主代理系统

3。职责3.1。设计,开发和实施为自治代理系统的代码,重点是但不限于专注于行为模型,因果模型,世界模型,优先级机制,奖励机制,社交交流机制和输入输出输出界面。3.2。使用内部和外部系统和基准评估和评估自主剂系统的性能。3.3。设计,开发和实施用于评估自主代理3.4的性能的系统。设计,开发和实施API功能和体系结构功能。3.5。编写代码以支持测试,分析,验证和验证代码库,包容性自主代理系统,性能评估系统,API系统和其他系统。3.6。考虑可扩展性,算法设计,基础架构以及云提供商系统和服务的整体系统设计,编排和部署。

海报:基于加强学习的自主行动的鲁棒性驱动到对抗性输入

在这项研究中,我们评估了自主驾驶(AD)系统中增强学习的鲁棒性(RL),特别是反对对抗攻击的稳健性。我们采用了Karavolos等人提出的基于Q学习的AD模型。[1]的简单性,是我们分析的基础。此选择使我们能够在简单的Q学习方法和更复杂的RL系统之间进行明显的比较。我们设计了两个威胁模型,以模拟对基于RL的广告系统的对抗性攻击。第一个模型涉及在RL模型的细调中注入未发现的恶意代码,使其容易受到对抗性扰动的影响,这可能会导致在特定的触发条件下碰撞。第二个威胁模型旨在通过直接改变RL模型在特定触发条件下的行动决策来引起碰撞,这代表了一种更隐秘的方法。基于这些威胁模型,我们对两种主要情况的实证研究提出:操纵传感器输入和直接对动作的扰动。研究结果表明,尽管基于RL的AD系统表现出针对传感器输入操纵的弹性,但在受到直接动作扰动时它们会表现出脆弱性。主要的和宽容的场景涉及更改传感器读数,例如在偏心转弯期间,这可能会误导系统并可能导致事故。这对于小误差很大的操作至关重要。第二种情况直接扰动动作,更多地是对基于RL的AD系统脆弱性的理论研究,而不是实用的现实世界威胁。

自主驾驶的广义预测模型

环境,建立内部世界模型表示,做出决策并采取措施[9,50]。,尽管数十年来在学术界和工业上做出了巨大的努力,但他们的部署仍限于某些杂物或场景,并且不能在世界上无缝地应用。一个关键原因是在结构化自主驾驶系统中学习模型的概括能力有限。通常,感知模型会面临概括到不同环境的挑战,随着地理位置,传感器配置,天气条件,开放式对象等的变化。;预测和计划模型无法推广到具有罕见的sce narios和不同驾驶意图的非确定性期货[2,16,54]。是由人类学习如何感知和刺激世界的动机[27,28,49],我们主张采用驾驶视频作为通用界面,将其推广到具有动态期货的各种环境。基于此,首选驱动视频预测模型以完全捕获有关驾驶场景的世界知识(图1)。通过预测未来,视频预测因子本质上了解了自主驾驶的两个重要方面:世界如何运作以及如何在野外安全地操纵。最近,社区已开始采用视频作为代表各种机器人任务的观察行为和行动的接口[11]。对于诸如经典视频预测和机器人技术等领域,视频背景大多是静态的,机器人的运动很慢,并且视频的分解很低。相比之下,对于驾驶场景 - iOS,它与室外环境高度斗争,代理人涵盖了更大的动作,以及涵盖众多视图的感觉分辨率。这些区别导致了自主驾驶应用的重大挑战。幸运的是,在驾驶领域中开发视频预测模型[4、15、19、23、23、25、33、38、45、47]。尽管在预测质量方面取得了令人鼓舞的进展,但这些尝试并未像经典的机器人任务(例如,操作)那样实现概括能力,仅限于有限的场景,例如流量密度低[4]的高速公路[4]和小型数据集[15,23,33,33,33,45,45,47],或者在环境方面进行不同的条件,以使38个条件(33,45,47)的差异(33,45,47),以使3个条件(33,45,47)的差异(33,45,47),以使3个条件(33,45,47)的差异[3](33,45,47),以下情况下的情况[3](33,33,45,47),这是3次差异。如何揭示视频预测模型的驾驶潜力仍然很少探索。以上面的讨论为动机,我们旨在构建一个自动驾驶的视频预测模型,能够概括为新的条件和环境。为此,我们必须回答以下问题:(1)可以以可行且可扩展的方式获得哪些数据?(2)我们如何制定一个预测模型来捕获动态场景的复杂演化?(3)我们如何将(基础)模型应用于下游任务?

自主量子设备:什么时候可以实现,而无需额外的热力学成本

鉴于化学行业对绿色和可持续技术的需求不断增长,他们的原子有效和选择性氧化反应代表了一个关键的挑战。 [1-5]一氧化二氮,N 2 O,在解决此问题中起着重要的作用。 虽然它是一种良好的特种化学物质,主要以其用作麻醉而闻名,但在1980年代,它已开始引起作为选择性氧化剂的大幅关注。 由于其捐赠单个氧原子的能力,它避免了过度氧化的风险,并且尤其是在生态上良性n 2作为唯一的副产品,将其作为许多常规氧化剂的绿色替代品。 [6-8]在接下来的几年中,N 2 O已被证明可以解锁苯对苯酚或甲烷至甲醇的一步氧化的独特途径。 [9,10]前者的高度选择性和便利性,导致了1990年代后期的Alphox过程。 在其中,Boreskov Institute鉴于化学行业对绿色和可持续技术的需求不断增长,他们的原子有效和选择性氧化反应代表了一个关键的挑战。[1-5]一氧化二氮,N 2 O,在解决此问题中起着重要的作用。虽然它是一种良好的特种化学物质,主要以其用作麻醉而闻名,但在1980年代,它已开始引起作为选择性氧化剂的大幅关注。由于其捐赠单个氧原子的能力,它避免了过度氧化的风险,并且尤其是在生态上良性n 2作为唯一的副产品,将其作为许多常规氧化剂的绿色替代品。[6-8]在接下来的几年中,N 2 O已被证明可以解锁苯对苯酚或甲烷至甲醇的一步氧化的独特途径。[9,10]前者的高度选择性和便利性,导致了1990年代后期的Alphox过程。在其中,Boreskov Institute在其中,Boreskov Institute