XiaoMi-AI文件搜索系统

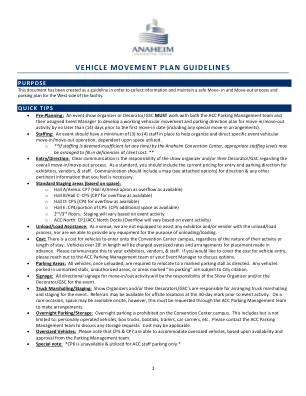

World File Search System车辆运动计划指南

o大厅A/竞技场:CP7(大厅A/Arena Apron作为可用的溢出)o hall b/hall c:cp5(cp7 for As -for -for -for -afor)o d:cp5:cp5(cp4 for for Aferflow for Ass -for,可用)e:e:cp4/cp4/cp4/cp5的cp5(cp5附加空间)o 2 nd/3 and acc o ac acc o acp a acp a acp a ac ac ac ac ac ac ac ac ac ac ac ac ac ac ac oc 2 acc上有很高码头(溢出会根据事件活动而变化)卸载/负载帮助:作为场地,我们没有能力为任何参展商和/或供应商提供卸载/加载过程,我们也无法为卸载/加载提供任何设备。成本:无论其活动的性质或住院时间如何,车辆都可以进入会议中心校园的费用。长度超过20'的车辆将收取超大费率和提前安置的安排。请与您的参展商,供应商和员工进行交流。如果您想支付车辆进入费用,请与ACC停车管理团队或您的活动经理联系以讨论选项。停车区:所有车辆(一旦卸载),必须按照指示搬迁到标记的停车位。任何停放在未标记的摊位,未经授权的地区或标记为“无停车场”的区域的车辆均受到城市含量的约束。标牌:搬进/输出活动的所有方向标牌将是演出组织者和/或活动的装饰者/GSC的责任。卡车编组/舞台:向组织者和/或他们的装饰人员/GSC展示,负责为活动安排卡车编组和演出。在活动活动之前,可以在30天标记的异地位置进行推荐。*在极少数情况下,可能会在现场提供空间,但是,必须通过ACC停车管理团队要求进行安排。过夜停车/存储:会议中心校园禁止过夜停车场。这包括但不限于;亲自操作的车辆,盒子卡车,板条,拖车,汽车运输车等。请联系ACC停车管理团队以讨论任何存储请求。成本可能适用。超大车辆:请注意,根据停车管理团队的可用性和批准,CP5&CP7能够容纳超大车辆。特别说明: *CP6不可用,仅用于ACC员工停车位。

层次运动计划和离线稳健模型的自动驾驶预测控制

摘要 - 在恶劣条件下在复杂情况下驾驶车辆是自动驾驶汽车(AV)的最大挑战。为了解决这个问题,我们在复杂的场景中使用前主动转向系统提出了层次运动计划和稳健的控制策略,并在各种湿滑的道路粘附系数中,同时考虑车辆不确定的参数。通过智能驾驶员模型(IDM)考虑并以车辆跟随模型的形式考虑人类车辆(HVS)的行为(HVS)。然后,在上层中,运动计划者首先使用人工电位场(APF)算法来生成最佳轨迹,例如,路标,边界和静态/动态障碍物,例如道路标记,边界和静态/动态障碍。为了在下层跟踪生成的最佳trajectory,通过应用线性矩阵不等式(LMI)优化方法,使用线性参数变化(LPV)系统来实现离线约束的输出反馈鲁棒模型预测性控制(RMPC),以确保对模型参数的鲁棒性不适合模型不限制。更重要的是,通过增强系统模型,我们提出的方法称为离线RMPC,与三种现有的RMPC方法相比,具有出色的效率,例如,偏置式挡板offline RMPC,在线rmpc,在线rmpc和离线rmpc无需增强模型(离线rmpc w/o am),在不线rmpc w/o am)(均改进了计算时间),并改进了计算时间和添加时间。

aign-aigment MPC敏捷和强大的脚步运动计划和控制

摘要 - 本文提出了一种在线两足动物的脚步计划策略,该策略结合了模型预测性控制(MPC)和增强学习(RL),以实现敏捷且健壮的两足动物。基于MPC的脚部放置控制器已经证明了它们在实现动态运动方面的有效性,但它们的性能通常受到使用简化模型和假设的限制。为了应对这一挑战,我们开发了一个新颖的脚放置控制器,该控制器利用了一项学识渊博的政策来弥合使用简化模型和更复杂的全阶机器人系统之间的差距。具体来说,我们的方法采用了基于ALIP的MPC脚部放置控制器的独特组合,用于次级脚步计划,并提供了精炼脚步调整的学习政策,从而使所得的脚步策略有效地捕获了机器人的全身动态。这种集成协同MPC的预测能力,其灵活性和适应性能力。我们通过使用全身人形机器人Draco3。结果表明,动态运动性能的显着改善,包括更好地跟踪各种步行速度,使可靠的转弯和穿越具有挑战性的地形,同时与基线ALIP ALIP ALIP MPC接近相比,保持步行步态的稳健性和稳定性。

IDB-A多级运动计划:光纤束配方

抽象的高维运动计划问题通常可以通过使用多级抽象来更快地解决。虽然有多种方式正式捕获多级抽象,但我们以纤维束的方式制定了它们。纤维束基本上使用本地产品空间来描述状态空间的低维投影,这使我们能够根据捆绑限制和捆绑截面来简化和得出新颖的算法。鉴于这种结构和相应的可允许约束函数,我们为高维状态空间开发了高度有效和基于最佳采样的运动计划方法。这些方法通过使用捆绑图来利用捆绑的结构。这些原语用于创建新颖的捆绑计划者,快速探索商的空间树(QRRT*)和商空间路线图计划者(QMP*)。两个计划者均显示出概率完整且几乎渐近地最佳。为了评估我们的捆绑计划者,我们将它们与四个低维情况的基准测试和基于经典的计划者进行了比较,以及八个高维场景,范围从21至100度的自由度不等,包括多个机器人和非健康的约束。我们的发现显示了多达2到6个数量级的改进,并强调了多级运动计划者的效率以及使用Fier Bundles的术语来利用多级抽象的有益。

敏捷自动驾驶汽车的实时运动计划

要允许复制或重新出版,请联系美国航空与宇航学院1801 Alexander Bell Drive,Suite 500,Reston,VA,20191–4344

类人机器人运动计划方法:调查

抽象的人形机器人是复杂的动态系统。任何类型机器人应用都始于确定在已知或未知环境中执行给定任务的一系列最佳路径序列。本文批判性地审查了有关人形机器人多级运动和任务计划的三个关键领域的可用文献。首先是在为人类设计的环境中导航和操纵对象时的效率。在这里,该研究已被总结为行为克隆方法。第二是在动态和不可预测的环境中操作引起的扰动和碰撞的鲁棒性。在这里,整合到运动计划算法中的建模方法一直是许多研究类人运动平衡和动态稳定性方面的研究人员的重点。最后是实时性能,其中,机器人必须根据最新的感官数据调整其运动,以实现所需的相互作用和响应性。在这里,重点是机器人的机械结构和关节运动施加的运动学约束。解决限制优化问题的迭代性质,向前和运动学的计算复杂性以及适应快速变化的环境的要求,所有对实时性能构成了挑战。这项研究已经确定了当前趋势,更重要的是,在指出需要进一步研究的领域,研究差距。

IDB-A 多级运动计划:光纤束配方

摘要 - 具有复杂动态的机器人系统的动态计划是一个具有挑战性的问题。最近基于抽样的算法通过传播随机控制输入来实现渐近最优性,但它们的经验收敛速率通常很差,尤其是在高维系统(如多电动器)中。另一种方法是使用简化的几何模型进行首先计划,然后使用轨迹优化来遵循参考路径,同时考虑真实动力学。但是,如果初始猜测不接近动态可行的轨迹,则此方法可能无法产生有效的轨迹。在本文中,我们提出了迭代的不连续性A*(IDB- a*),这是一种新型的运动动力运动计划者,可以迭代地结合搜索和优化。搜索步骤利用了有限的短轨迹(运动原语),这些轨迹是相互互连的,同时允许它们之间存在界限的不连续性。优化步骤在本地通过轨迹优化的不连续性进行了修复。通过逐步降低允许的不连续性并结合更多的运动原始性,我们的算法可实现渐近最优性,并在任何时候表现出色。我们提供了八个不同动力学系统的43个问题的基准,包括不同版本的独轮和多旋转器。与最先进的方法相比,IDB-A*始终如一地解决了更多的问题实例,并更快地发现了较低成本的解决方案。

剧院策略和剧院运动计划-DTIC

t是一个联合工作人员将新强调联合使用的时代。然而,一名剧院指挥官计划根据他的戏剧运动计划雇用联合部队,而另一位避免了竞选活动,计划在很大程度上基于他的“战斗策略”进行联合行动。什么给?是否应该有一个具有约束力的联合学说来为战争剧院做准备?CINC是否应该既有剧院战略,又有竞选计划吗?我认为这两个问题的答案是肯定的。尽管我们的剧院指挥官长期以来一直倾向于做自己的方式做事,但联合规划学说应该比过去几年相比发展成为一种更集中的方法。本文提供了戏剧战略与相关竞选计划之间正确关系的一个愿景。我不会假装它是唯一甚至最好的愿景,但我确实希望它会在我们开始建立将我们的统一力量进入下个世纪的联合学说的过程中进行认真的思想和讨论。 '1986年的《戈德沃特·尼科尔斯国防部的重组法》,1987年的参议院关于国家安全战略的听证会以及1988年的总统国家安全战略报告鼓励人们对国家军事战略,联合互操作性以及我们在战略和运营水平上的统一战斗有效性重新兴趣。”,但他们不处理诸如戏剧指挥官为什么在存在控制国家军事战略的情况下,为什么将政治目标与剧院任务联系起来的肠道问题。我们的国家军事战略起源于我们的全国性 - 我们作为一个国家的集体关注和价值观。自第二次世界大战以来,这些政治,军事,经济和心理敏感性在各种官方宣言中都表现出来。

人形运动的运动计划:对家乡环境的应用

摘要 - “您的人形机器人可以做什么?”我们作为机器人主义者在与公众互动时必须回答的最常见问题可能是最常见的问题。通常,这个问题是在熟悉的家庭或办公室环境中构成的,暗示着对不平坦和混乱的地形的强大运动的期望,以及与人,物体和环境的合规互动。的问题暗示了人类机器人在运动计划者实施的一组体现的机车操作技巧的存在,这些技能是在给定相应命令时可检索的。在本文中,我们以有效,模块化和可扩展的运动计划者的形式为该问题提出答案。我们在三种具有挑战性的情况下演示了它的用途,旨在突出机器人的安全操作及其在非结构化环境中的精确运动。此外,我们讨论了从我们在扭矩控制的人形机器人实际实施方面的经验中得出的关键技术。