XiaoMi-AI文件搜索系统

World File Search System可再生能源预测的未来

随着风能和太阳能可再生能源发电量的增加,对这些能源的预测变得越来越重要。预测技能正在提高,但预测的使用方式也在提高。在本文中,我们简要概述了风能和太阳能预测的最新进展。我们描述了从几分钟到几天时间尺度的统计和物理建模方法,包括确定性和概率性预测。然后我们的重点转移到考虑可再生能源预测的未来。我们讨论了最近的进展,这些进展表明预测技能有巨大的改进潜力。除了预测本身,我们还考虑了在风险约束下辅助决策所需的新产品。未来的预测产品将需要包含概率信息,但要以适合最终用户及其特定决策问题的方式提供这些信息。随着越来越多的人在这个领域竞争,在这个领域运营的企业可能会看到商业模式的变化,不同的产品需要不同的技能、数据和建模组合。随着区块链技术的采用,数据交易本身可能会发生变化,区块链技术可以让提供商和最终用户以可信但去中心化的方式进行交互。最后,我们讨论了可再生能源大量使用的情况下的新行业要求和挑战。新的预测产品有可能模拟可再生能源对电力系统的影响,并帮助调度工具保证系统安全。

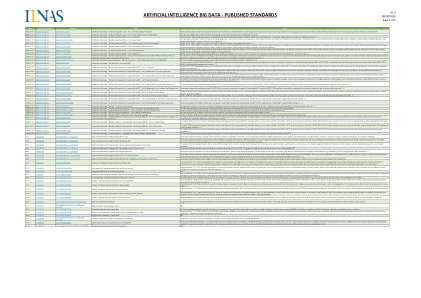

人工智能 大数据

ISO/IEC JTC 1 ISO/IEC JTC 1/SC 32 ISO/IEC 15944-10 信息技术 -- 业务运营视图 -- 第 10 部分:IT 支持的编码域作为业务交易中的语义组件 ISO/IEC JTC 1 ISO/IEC JTC 1/SC 32 ISO/IEC TR 15944-14 信息技术 -- 业务运营视图 -- 第 14 部分:开放式 EDI、模型和云计算架构 ISO/IEC JTC 1 ISO/IEC JTC 1/SC 42 ISO/IEC 22989 人工智能 -- 概念和术语 ISO/IEC JTC 1 ISO/IEC JTC 1/SC 42 ISO/IEC 23053 使用机器学习(ML)的人工智能(AI)系统框架 ISO/IEC JTC 1 ISO/IEC JTC 1/SC 42 ISO/IEC TR 24027 信息技术 -- 人工智能(AI) -- 人工智能系统中的偏见和人工智能辅助决策 ISO/IEC JTC 1 ISO/IEC JTC 1/SC 42 ISO/IEC TR 24030 信息技术 -- 人工智能(AI) -- 使用案例 ISO/IEC JTC 1 ISO/IEC JTC 1/SC 42 ISO/IEC TR 24372 信息技术 -- 人工智能(AI) -- 人工智能系统计算方法概述 ISO/IEC JTC 1 ISO/IEC JTC 1/SC 42 ISO/IEC 24668 信息技术 — 人工智能 — 大数据分析流程管理框架

印度未来航空航天战争控制与报告系统的演变

那是 1912 年;在欧洲一个寒冷的夜晚,一名土耳其士兵在意土战争中击落了一架意大利飞机。1 尽管射击飞机是人类击落敌人的固有行为,但那名士兵几乎不知道,他的行为将成为改变全球军事概念的历史的一部分。“这个概念就是防空”。很快,人们意识到了阻止敌人使用空中维度的重要性,并开始了争夺空中优势的战斗。这几乎不是时间问题,世界各地的军队将开始争夺太空优势,从而战争将从空域延伸到太空。历史上有一些关键点,个人或组织的行动会改变未来的战争进程。作为负责国家防空的机构,印度空军 (IAF) 今天正处于其中一个关键点。我们从现在开始选择的道路将决定我们适应未来航空航天领域网络中心作战所引领的范式变化的能力。印度空军目前处于转型状态已有相当长一段时间,并且在各方面不断专业化发展。在任何指挥和控制系统中,引入和联网大量最先进的系统是绝对必要的,以便提供更高程度的战场透明度。这反过来会提高任何空军系统的态势感知能力。印度空军引入自动化指挥和控制系统(也称为综合空中指挥和控制系统 (IACCS))也标志着技术领域的一个重要里程碑,其中系统辅助决策成为大幅减少人为错误因素的关键辅助手段。2

从标准到算法 - 电子档案

网络控制、管理和编排需要在网络功能虚拟化 (NFV) 基础设施中动态放置、配置和调配虚拟网络功能 (VNF)。这些操作的复杂性大大超过了传统 4G LTE 网络中的等效任务。在那里,一刀切的核心和无线接入网络域中相对有限的变量数量适应了主要依赖专家监控和干预的管理模式。相反,传统的以人为本的方法在虚拟化的 5G 网络中几乎不可行,因为异构移动服务、多样化网络需求和租户定义的管理策略共存,需要专门的和随时间变化的基础设施部署。这反过来又要求在网络的控制、管理和编排方面采用自动化解决方案。人工智能 (AI) 是支持新兴的自主网络运营和管理需求的自然选择。3GPP 和其他标准开发组织 (SDO) 已开始规划将 AI 集成到移动网络架构中的道路。这一过程始于在网络基础设施中有效收集数据并从这些数据中进行知识推理,这对于有效的 AI 辅助决策至关重要。从这个意义上说,SDO 正在努力定义基于 AI 的数据分析框架,这些框架适用于自主和高效的移动网络控制、管理和编排。例如,3GPP 已将以下模块纳入其标准化架构:(i) 网络数据

chong-进化-jmd.pdf

在设计过程中,人工智能 (AI) 的决策辅助只有当人类设计师正确利用 AI 输入时才会有效。然而,设计师经常会误判 AI 和/或他们自己的能力,导致错误地依赖 AI,从而出现糟糕的设计。为了避免这样的结果,了解设计师在 AI 辅助决策过程中对 AI 队友和自己的信心的演变至关重要。因此,这项工作进行了一项认知研究,以探索如何体验各种变化(未经通知)的 AI 性能水平,并且反馈会影响这些信心,从而影响接受或拒绝 AI 建议的决策。结果首先表明,设计师对 AI 代理的信心会随着 AI 性能不佳而变化,但不会随着 AI 性能良好而变化。有趣的是,设计师的自信最初不受 AI 准确性的影响;然而,当准确度发生变化时,无论变化方向如何,自信度都会下降。此外,这项研究发现,设计师倾向于从反馈中推断出有缺陷的信息,导致对人工智能和他们自己的自信度都不适当。这项研究还表明,对人工智能的信心和自信度会影响设计师以相反方向接受人工智能输入的概率。最后,通过将这项研究的结果与针对非设计任务进行的类似研究的结果进行比较,确定了只适用于设计的结果。总的来说,这项研究提供了有价值的见解,可能有助于检测设计师的动态信心及其在设计中对人工智能输入的误用。[DOI: 10.1115/1.4055123]

智能部署的社会经济评估...

本报告是对卢森堡埃特尔布吕克市实施的智能停车项目的社会经济评估。该项目采用了由法国公司 UPCITI 开发的智能停车技术,该公司生成并向公众提供实时数据,旨在使城市变得更加智能。该项目与 RMS.lu 合作实施,后者是一家位于埃特尔布吕克的公司,专门开发、安装和支持自动识别和移动解决方案。智能停车项目于 2019 年 10 月实施,可以实时监控城市的传统停车位以及为行动不便人士 (PMR)、电动汽车、送货人员和出租车预留的停车位。由于城市司机花费大量时间寻找停车位,这些技术不仅可以帮助司机节省时间,还可以通过减少寻找停车位时燃烧的燃料量来减少二氧化碳排放和空气污染。它们还有助于减少因交通拥堵而产生的噪音污染。正是出于这种观点,埃特尔布吕克 (Ettelbruck) 启动了智能停车项目,该市的目标是成为一座智能城市,目前正处于为此目的试验解决方案的早期阶段。公共投资的社会经济评估是一种辅助决策的工具:它允许通过成本效益分析,质疑项目在给定时间段内为所有受影响的参与者产生的集体价值与其成本相比。社会经济评估有三个主要特点:• 首先,与财务评估相反,它不仅考虑财务

生物制剂的研究进展

老年发作的类风湿关节炎(EORA)是类风湿关节炎的独特亚型,其特征是由于免疫老化和合并症的复杂性而引起的治疗挑战增加。本综述系统地总结了定义,临床特征,流行病学趋势,治疗挑战以及生物学剂在EORA中的潜在应用。它主要关注与各种生物学剂相关的效率,安全性和个性化治疗策略。研究表明,生物制剂,例如TNF-α抑制剂,IL-6抑制剂和JAK抑制剂,可以显着降低EORA患者的炎症并改善关节功能。但是,它们的长期使用与增加感染,血栓形成和恶性肿瘤的风险密切相关,强调了个性化治疗方法的重要性和动态监测。此外,包括IL-17和IL-23抑制剂在内的新型生物学剂的出现以及第二代JAK抑制剂为难治性患者提供了其他治疗选择,并在优化效率和安全性方面具有巨大的潜力。随着精密医学和人工智能(AI)技术的快速进步,基因专业,生物标志物分析和AI辅助决策,逐渐将EORA治疗转向更具个性化和精确的策略。但是,在临床实践中,这些技术的高度治疗成本和有限的可及性仍然是显着的障碍。未来的研究应着重于验证新型疗法的长期安全性并重新发现个性化治疗策略,以增强患者的预后和生活质量。

人工智能背景下的责任问题

人工智能(AI)增强了效率,生产和决策,已迅速成为医疗保健,银行业,教育和运输等部门的关键组成部分。但是,随着AI系统越来越多地整合到日常生活的关键方面,与责任,透明度和问责制有关的重大法律挑战。问题是,为AI做出的判断归咎于责任可能是一个挑战,尤其是在涉及自学系统并超越初始编程时。除了算法偏见,不透明的决策程序和第三方参与外,开发人员,运营商和用户的问责制分配中还有歧义。本研究的目的是讨论这些法律问题,并提供可行的答案,以确保AI辅助决策中的公平和责任。为了通过强调因果关系而不是犯罪性来简化补偿,关键发现建议对高风险AI应用程序实施严格的责任。通过所需的文书工作和可解释的AI系统,可以通过提高透明度来提高问责制和可追溯性。可以通过使用明确的合同框架清楚地为开发人员,运营商和用户定义角色来降低不确定性。此外,创建专业责任保险可以在为利益相关者提供财务保护的同时促进适当使用AI。建立公众信任并确保AI在不危害的情况下促进社会的发展,需要在创新与道德和法律义务之间取得平衡。跨境AI申请要求国际法律规范(例如GDPR和欧盟的AI法案)进行国际协调,以建立统一的监管框架。为了确保正义,公平和社会的福祉,这些广泛的法律改革需要弥补问责制和技术创新之间的差距。

人工智能技术中的残疾模型和偏见机制

人工智能 (AI) 工具越来越多地用于为医疗保健、就业、社会福利和政府政策等不同领域的决策提供信息,这对残疾人来说是一个严重的风险,因为事实证明,残疾人在 AI 实施中会面临偏见。虽然在分析和减轻算法偏见方面已经开展了大量工作,但人们对 AI 应用中偏见出现的更广泛机制尚不甚了解,这阻碍了从源头上解决偏见的努力。在本文中,我们说明了 AI 辅助决策中的偏见如何源于一系列特定的设计决策,如果单独考虑,每个设计决策似乎都是独立且无偏见的。这些设计决策包括基本问题的表述、选择用于分析的数据、AI 技术的用途以及除核心算法设计之外的操作设计元素。我们借鉴了不同决策环境中常见的三种历史残疾模型,以说明残疾定义的差异如何导致设计的每个方面都做出截然不同的决策,进而导致 AI 技术具有各种偏见和下游影响。我们进一步表明,由于整个 AI 设计过程缺乏透明度和残疾人参与,基础设计阶段对残疾的不恰当定义可能造成的潜在危害进一步加剧。我们的分析提供了一个框架,用于在决策环境中批判性地审查 AI 技术,并指导残疾相关 AI 分析的设计实践的发展。我们提出这篇文章是为了提出关键问题,以促进由残疾人主导的设计和参与式发展,从而在残疾相关环境中产生更公平、更公正的 AI 技术。

人类合作对决策的影响 -

简介:随着人工智能(AI)技术越来越多地整合到业务运营的各个方面,人们对了解人类协作如何影响管理中的决策越来越兴趣。本研究旨在调查这种协作对管理环境中决策过程的影响。问题陈述:随着AI系统变得更加复杂,人们担心它们如何影响传统的管理角色和决策过程。了解人类协作在决策中的动态 - 对于组织有效利用这些技术的同时确保人类的监督和问责制是至关重要的。目的:这项研究的主要目的是分析人类合作对管理决策的影响。具体来说,该研究旨在检查不同合作模型的有效性,确定影响决策成果的因素,并评估人类判断在AI-ASS辅助决策过程中的作用。方法论:将采用一种多学科的方法,借鉴了伦理,计算机科学和社会学的文献。定性分析技术将被用来分析来自各个管理层和行业的现有案例研究,道德框架和利益相关者,将参与模拟决策任务,从而探索不同的协作模型和决策环境。结果:预计这项研究的结果将提供有关管理决策中人类协作的优势和局限性的见解。对决策结果,参与者反馈和绩效指标的分析将阐明有效协作以及AI技术最佳集成到管理过程中的因素。结论:通过了解人类协作如何影响管理中的决策,组织可以制定策略来最大程度地利用AI的好处,同时减轻潜在的风险。这项研究有助于在组织环境中对AI采用的知识越来越多,并为利用AI技术增强决策过程的最佳实践提供了信息。