机构名称:

¥ 1.0

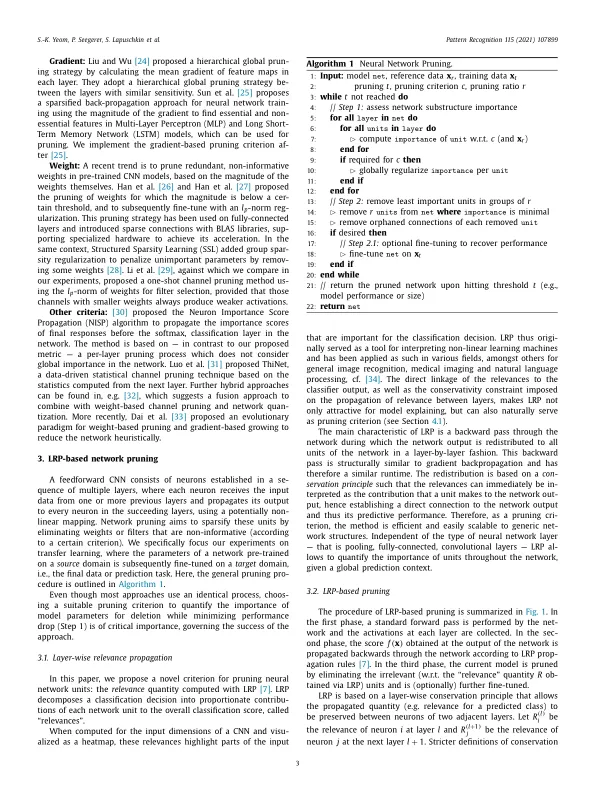

卷积神经网络 (CNN) 在各种应用中的成功伴随着计算和参数存储成本的显著增加。最近为减少这些开销所做的努力包括修剪和压缩各个层的权重,同时力求不牺牲性能。在本文中,我们提出了一种受神经网络可解释性启发的 CNN 修剪新标准:使用从可解释人工智能 (XAI) 概念中获得的相关性分数,自动找到最相关的单元,即权重或过滤器。通过探索这个想法,我们将可解释性和模型压缩研究联系起来。我们表明,我们提出的方法可以在迁移学习设置中有效地修剪 CNN 模型,在这种设置中,在大型语料库上预训练的网络可以适应专门的任务。该方法在广泛的计算机视觉数据集上进行了评估。值得注意的是,我们的新标准不仅在进行连续再训练时与最先进的修剪标准相比具有竞争力或更好,而且在资源受限的应用场景中,其表现明显优于这些先前的标准,在这种场景中,要迁移到的任务的数据非常稀缺,并且人们选择不进行微调。我们的方法能够迭代压缩模型,同时保持甚至提高准确性。同时,它的计算成本与梯度计算的数量级相当,并且应用起来相对简单,无需调整修剪的超参数。

深度神经网络剪枝的新标准

主要关键词