机构名称:

¥ 2.0

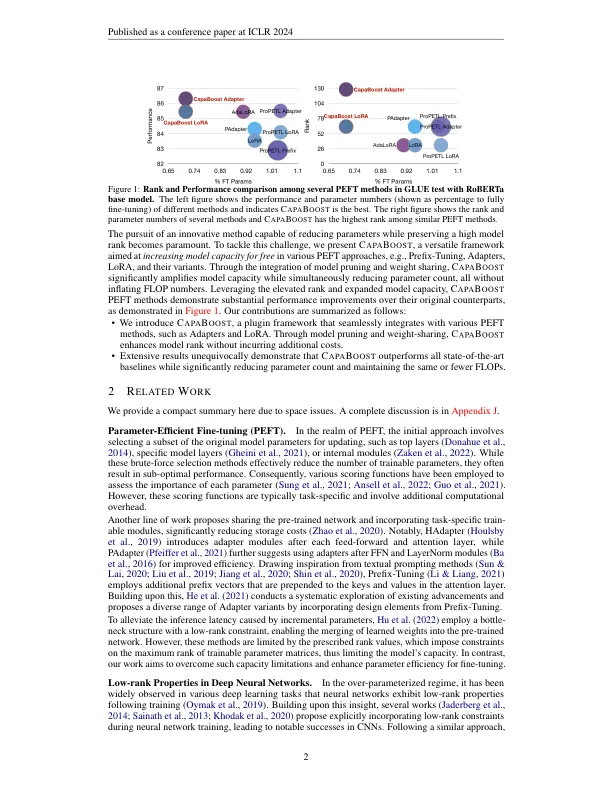

最近,对大型预训练基础模型(例如 175B GPT-3)进行微调引起了更多下游任务的关注。虽然已经提出了参数高效的微调方法,并且无需重新训练所有模型参数就被证明是有效的,但它们的性能受到增量模块容量的限制,尤其是在参数预算受限的情况下。为了克服这一挑战,我们提出了 C APA B OOST,这是一种简单而有效的策略,它通过目标层中的并行权重模块利用低秩更新来增强模型容量。通过将静态随机掩码应用于共享权重矩阵,C APA B OOST 构建了一组多样化的权重矩阵,从而无需添加参数即可有效地提高增量权重的秩。值得注意的是,我们的方法可以无缝集成到各种现有的参数高效的微调方法中。我们通过对自然语言理解、问答和图像分类等各种下游任务的实验,广泛验证了 C APA B OOST 的有效性。我们的结果表明,与基线相比,我们有显着的改进,而不会产生额外的计算或存储成本。我们的代码可以在https://github.com/LINs-lab/CapaBoost上找到。

免费增加模型容量:简单...