机构名称:

¥ 1.0

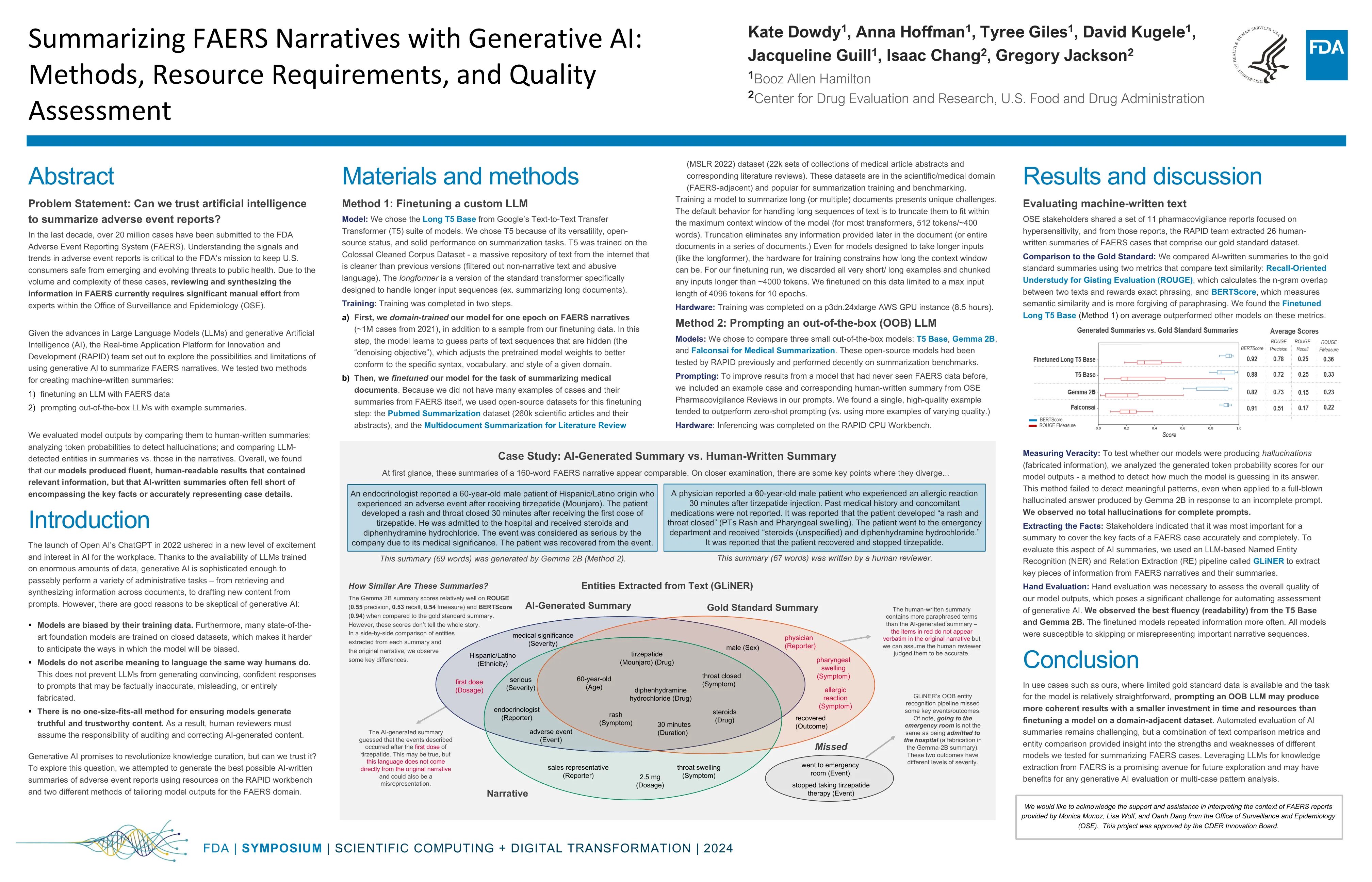

(MSLR 2022)数据集(22k 组医学文章摘要和相应的文献综述)。这些数据集属于科学/医学领域(FAERS 相邻),常用于摘要训练和基准测试。训练模型来总结长篇(或多篇)文档提出了独特的挑战。处理长文本序列的默认行为是截断它们以适合模型的最大上下文窗口(对于大多数 Transformer,512 个标记/~400 个单词)。截断会消除文档后面提供的任何信息(或一系列文档中的整个文档)。即使对于设计为接受更长输入的模型(如 longformer),用于训练的硬件也会限制上下文窗口的长度。对于我们的微调运行,我们丢弃了所有非常短/长的示例,并将任何长度超过 ~4000 个标记的输入分块。我们对此数据进行了微调,将最大输入长度限制为 4096 个标记,持续 10 个时期。

使用生成式 AI 总结 FAERS 叙述