机构名称:

¥ 3.0

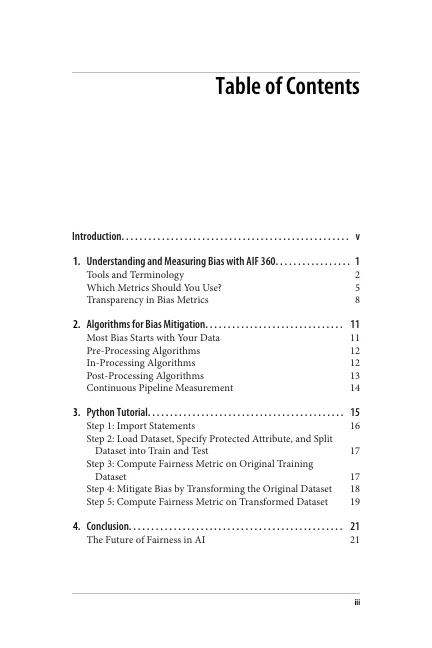

大量证据表明,人工智能可以嵌入人类和社会偏见,并大规模部署它们。许多专家现在表示,不必要的偏见可能是阻碍人工智能发挥其全部潜力的主要障碍。一个引起媒体关注的案例是惩教罪犯管理分析替代制裁 (COMPAS),该算法用于预测佛罗里达州布劳沃德县等司法管辖区的被告如果不被还押,是否有可能犯罪。ProPublica 记者在 2016 年进行的一项调查发现,COMPAS 算法错误地将非裔美国人被告标记为“高风险”,其错误率几乎是错误标记白人被告的两倍。这说明了人工智能算法可能对社会产生的重大负面影响。那么我们如何确保自动决策比人类决策更少偏见?

AI 公平性

主要关键词