机构名称:

¥ 1.0

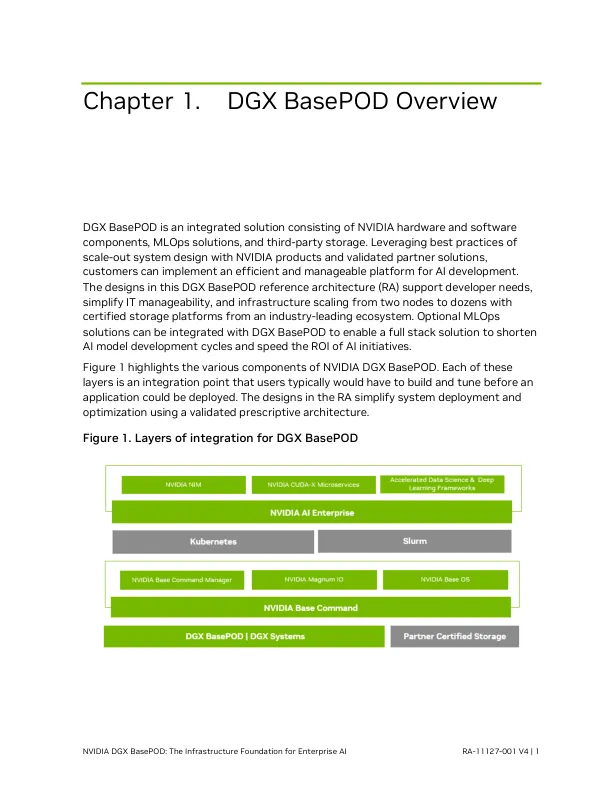

企业内部 AI 的使用案例数量(包括语言建模、网络安全、自主系统和医疗保健等)持续快速增长。不仅使用案例数量在增长,模型复杂性和数据源也在增长。处理、训练和服务这些下一代模型所需的系统也必须增长。训练模型通常使用数十个 GPU 来评估和优化不同的模型配置和参数。对于这些新的工作负载,所有 GPU 都必须能够轻松访问训练数据。此外,组织有许多 AI 研究人员必须同时训练多个模型。企业需要灵活性,以便多个开发人员和研究人员在完善 AI 堆栈并将其投入生产时共享这些资源。

NVIDIA DGX BasePOD:企业 AI 的基础设施基础

主要关键词