机构名称:

¥ 1.0

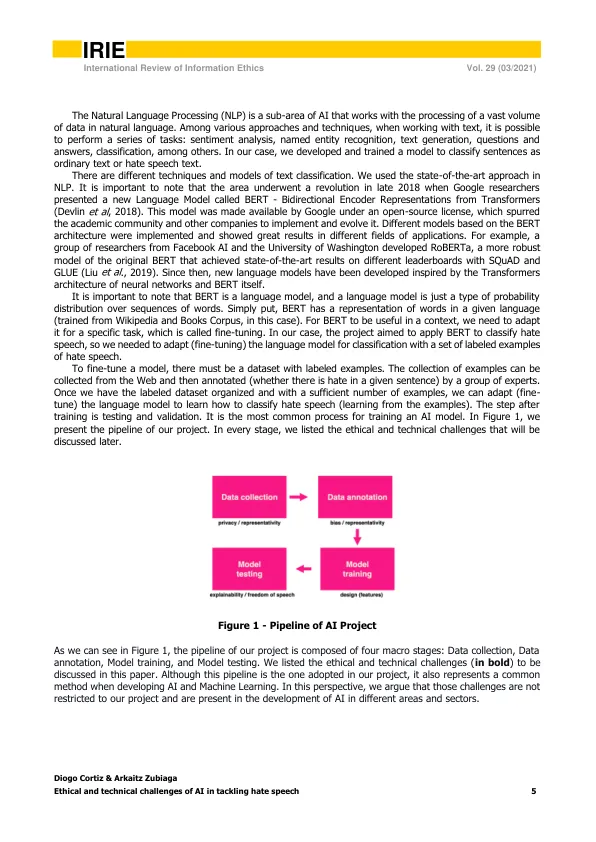

摘要:在本文中,我们讨论了使用人工智能进行在线内容审核的一些道德和技术挑战。作为一个案例研究,我们使用了一个为检测社交网络上的仇恨言论而开发的人工智能模型,这一概念在科学文献中给出了不同的定义,并且缺乏共识。我们认为,虽然人工智能可以在处理社交媒体上的信息过载方面发挥核心作用,但它可能会导致侵犯言论自由的风险(如果项目执行不当)。我们介绍了人工智能项目整个流程中涉及的一些道德和技术挑战——从数据收集到模型评估——这些挑战阻碍了仇恨言论检测算法的大规模使用。最后,我们认为人工智能可以帮助检测社交媒体中的仇恨言论,前提是必须通过有人参与的过程对内容进行最终判断。关键词:人工智能、道德、网络危害、仇恨言论、偏见大纲:1.2

人工智能在打击仇恨言论方面面临的道德和技术挑战