机构名称:

¥ 1.0

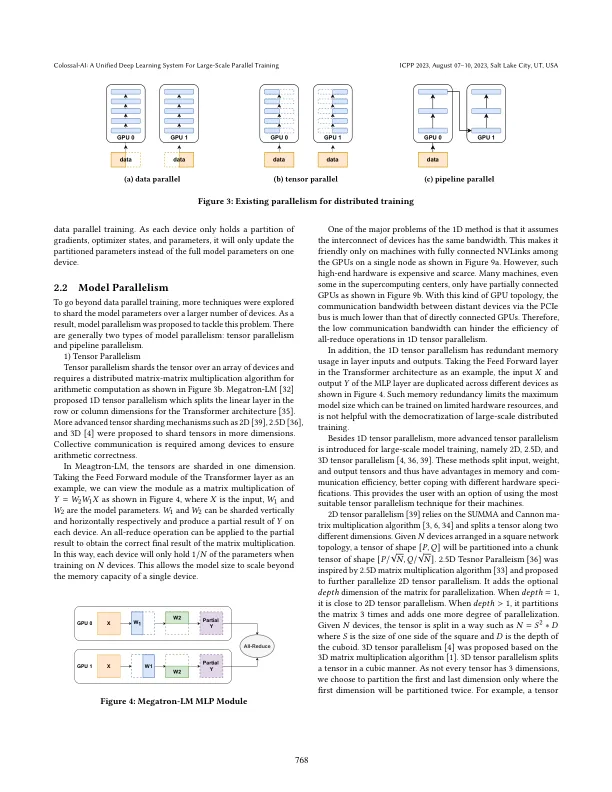

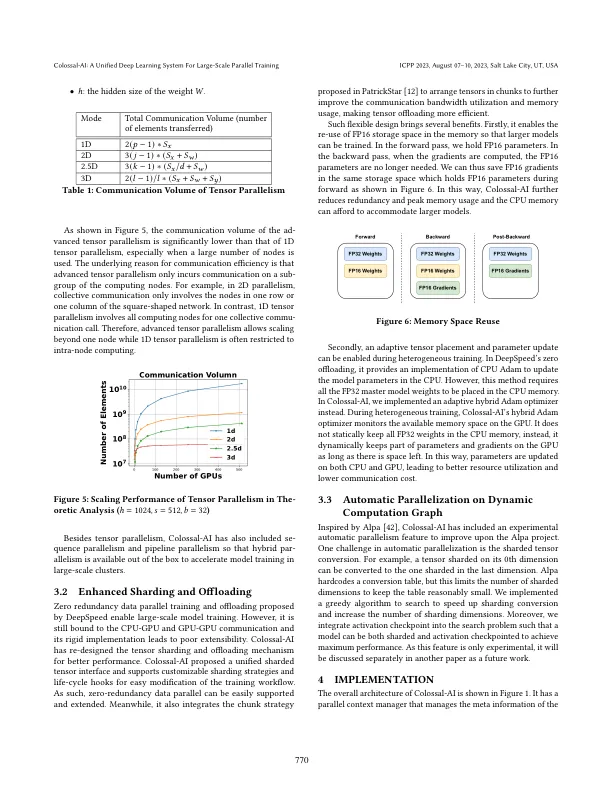

Transformer 模型的成功将深度学习模型规模推向了数十亿参数,但单 GPU 的内存限制导致在多 GPU 集群上进行训练的需求迫切。然而,选择最优并行策略的最佳实践仍然缺乏,因为它需要深度学习和并行计算领域的专业知识。Colossal-AI 系统通过引入统一接口将模型训练的顺序代码扩展到分布式环境,解决了上述挑战。它支持数据、管道、张量和序列并行等并行训练方法,并集成了异构训练和零冗余优化器。与基线系统相比,Colossal-AI 在大规模模型上可以实现高达 2.76 倍的训练加速。

Colossal-AI:用于大规模并行训练的统一深度学习系统