机构名称:

¥ 1.0

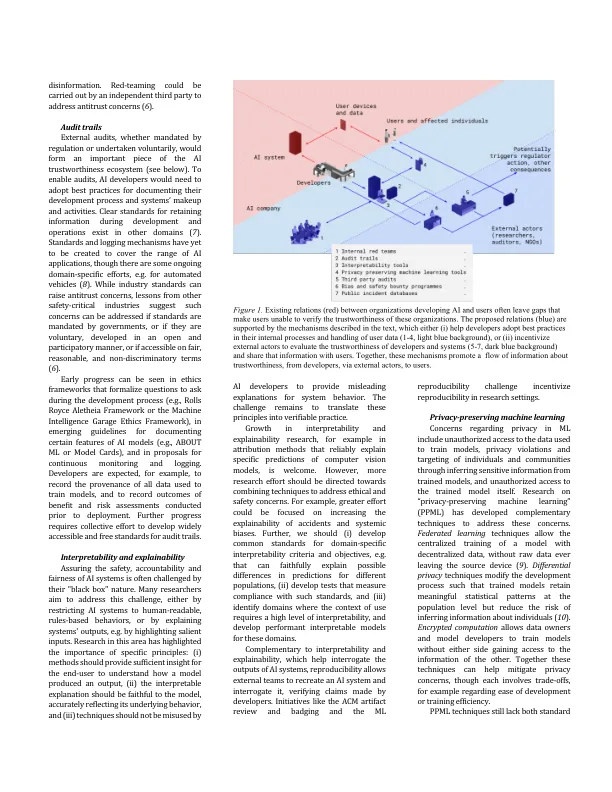

人工智能 (AI) 的应用范围非常广泛,造成危害的可能性也非常大。人们越来越意识到人工智能系统的潜在风险,这促使人们采取行动应对这些风险,同时也削弱了人们对人工智能系统及其开发组织的信心。2019 年的一项研究 ( 1 ) 发现,已有 80 多个组织发布并采用了“人工智能道德原则”,此后还有更多组织加入。但这些原则往往在值得信赖的人工智能开发的“内容”和“方式”之间留下了空白。这种差距导致了可疑或道德上可疑的行为,这让人们对特定组织以及整个领域的可信度产生了怀疑。因此,迫切需要具体的方法,既能让人工智能开发人员防止危害,又能让他们通过可验证的行为证明自己的可信度。下面,我们将探讨创建生态系统的机制(摘自 ( 2 )),在这个生态系统中,人工智能开发人员可以赢得信任——如果他们值得信赖的话。更好地评估开发人员的可信度可以为用户选择、员工行为、投资决策、法律追索权和新兴治理制度提供信息。

填补人工智能可信开发的空白