机构名称:

¥ 1.0

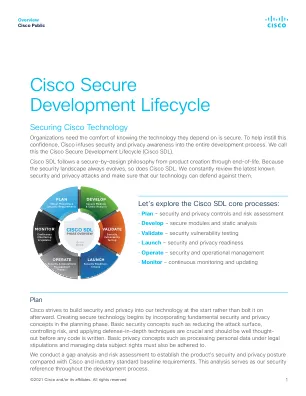

世界各地的立法和公众情绪都将公平性指标、可解释性和可解释性作为负责任地开发道德人工智能系统的规定。尽管这三大支柱在该领域的基础中发挥着重要作用,但它们的操作性却具有挑战性,而在生产环境中解决这些问题的尝试往往让人感觉是西西弗斯式的。这种困难源于许多因素:公平性指标在计算上难以纳入训练中,而且很少能减轻这些系统造成的所有危害。可解释性和可解释性可以被玩弄以显得公平,可能会无意中降低训练数据中包含的个人信息的隐私,并增加用户对预测的信心——即使解释是错误的。在这项工作中,我们提出了一个负责任地开发人工智能系统的框架,通过结合信息安全领域和安全开发生命周期的经验教训来克服在对抗环境中保护用户所面临的挑战。具体来说,我们建议在开发人工智能系统的背景下利用威胁建模、设计审查、渗透测试和事件响应的概念来解决上述方法的缺点。

迈向负责任的 AI 开发生命周期

主要关键词