机构名称:

¥ 1.0

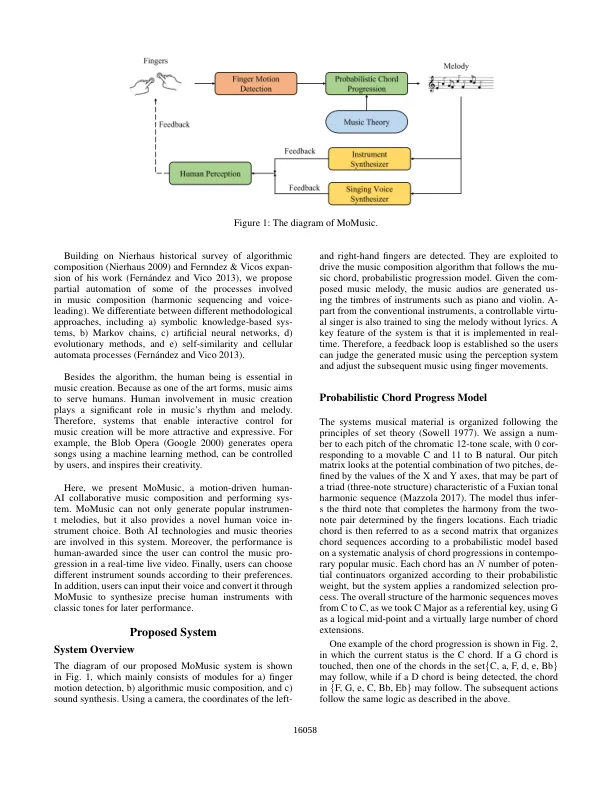

过去几年,人工神经网络架构的重大发展促进了自动音乐创作模型的广泛应用。然而,大多数现有系统都采用基于硬代码和预定义规则的算法生成结构,通常不包括交互式或即兴行为。我们提出了一种基于运动的音乐系统 MoMusic,作为 AI 实时音乐生成系统。MoMusic 具有部分随机谐波排序模型,该模型基于音调和弦进展的概率分析,通过音乐集合论进行数学抽象。该模型针对二维网格呈现,通过姿势识别机制产生结果声音。摄像头捕捉用户手指的运动和轨迹,创造出连贯的、部分即兴的和声进程。MoMusic 集成了多个音色音域,从钢琴等传统古典乐器到使用语音转换技术创建的新型“人声乐器”。我们的研究证明了 MoMusic 的互动性、激发音乐家灵感的能力以及使用各种音色音域生成连贯音乐材料的能力。MoMusic 的功能可以轻松扩展,以结合不同形式的姿势控制音色变换、节奏变换、动态变换甚至数字声音处理技术。

MoMusic:一种运动驱动的人机协作音乐创作和表演系统