机构名称:

¥ 2.0

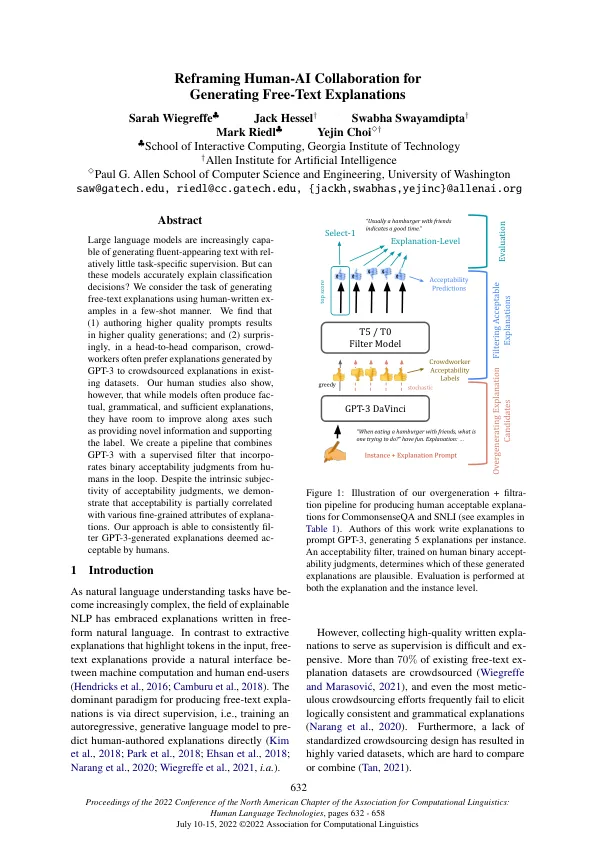

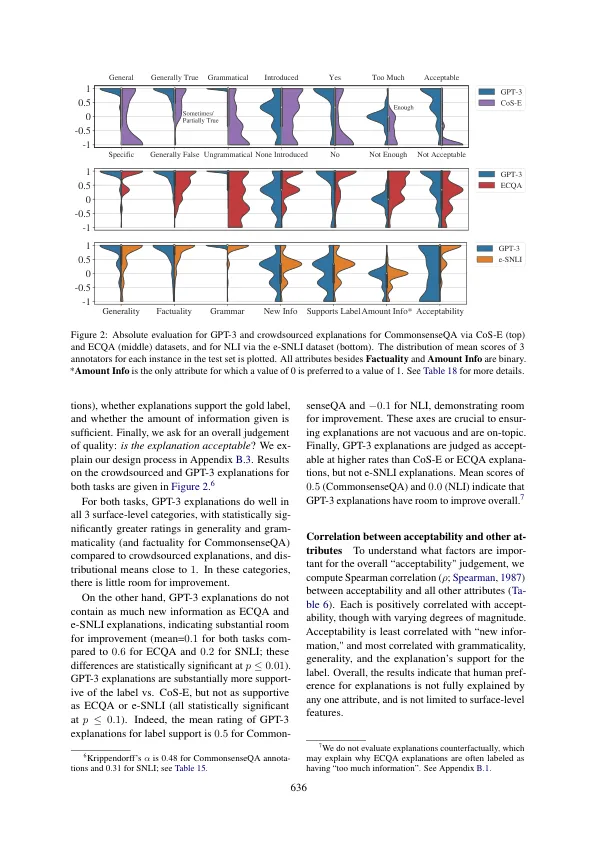

大型语言模型越来越能够在相对较少的任务特定监督下生成流畅的文本。但这些模型能准确地解释分类决策吗?我们考虑使用人工编写的示例以少量方式生成自由文本解释的任务。我们发现 (1) 编写更高质量的提示会产生更高质量的生成; (2) 令人惊讶的是,在面对面的比较中,众包工作者通常更喜欢 GPT-3 生成的解释,而不是现有数据集中的众包解释。然而,我们的人类研究还表明,虽然模型通常会产生事实、语法和充分的解释,但它们在提供新信息和支持标签等方面还有改进空间。我们创建了一个管道,将 GPT-3 与一个监督过滤器相结合,该过滤器将来自人类的二元可接受性判断纳入循环中。尽管可接受性判断具有内在的主观性,但我们证明可接受性与解释的各种细粒度属性部分相关。我们的方法能够一致地过滤 GPT-3 生成的被人类认为可以接受的解释。

重新构建人机协作以生成自由文本解释