机构名称:

¥ 1.0

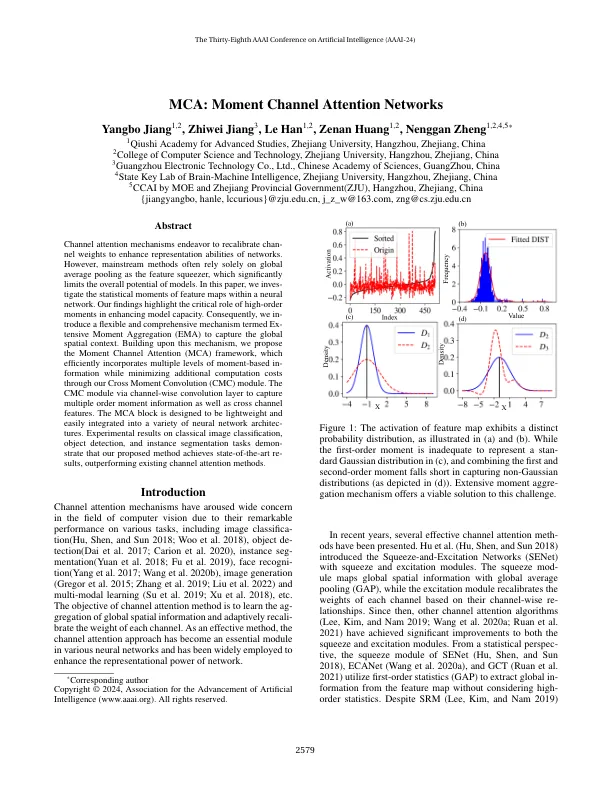

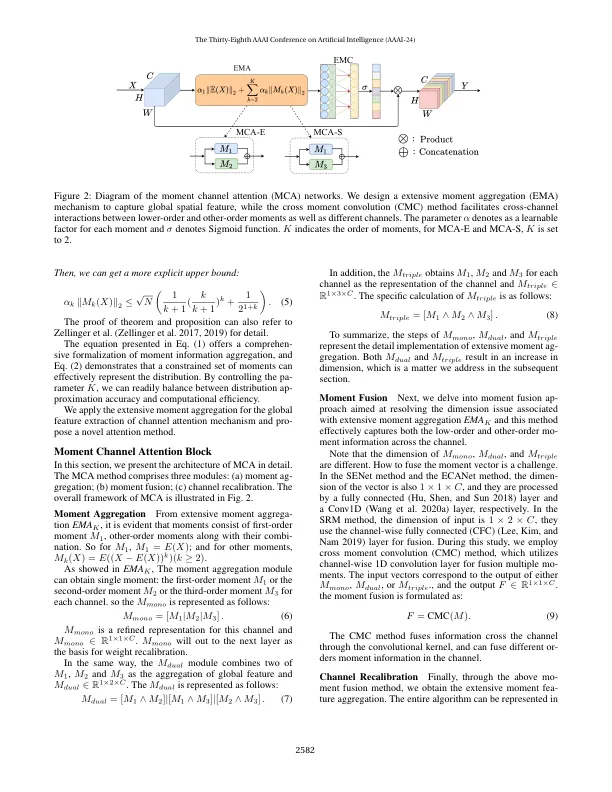

通道注意机制致力于重新校准通道权重以增强网络的表示能力。然而,主流方法通常仅依赖全局平均池化作为特征压缩器,这显著限制了模型的整体潜力。在本文中,我们研究了神经网络中特征图的统计矩。我们的研究结果强调了高阶矩在增强模型容量方面的关键作用。因此,我们引入了一种灵活而全面的机制,称为广泛矩聚合 (EMA),以捕获全局空间上下文。基于该机制,我们提出了矩通道注意 (MCA) 框架,该框架通过我们的交叉矩卷积 (CMC) 模块有效地整合了多层基于矩的信息,同时最大限度地降低了额外的计算成本。CMC 模块通过逐通道卷积层捕获多阶矩信息以及跨通道特征。MCA 模块设计为轻量级,可轻松集成到各种神经网络架构中。在经典图像分类、目标检测和实例分割任务上的实验结果表明,我们提出的方法取得了最先进的结果,优于现有的通道注意方法。

MCA:矩通道注意力网络

主要关键词