机构名称:

¥ 1.0

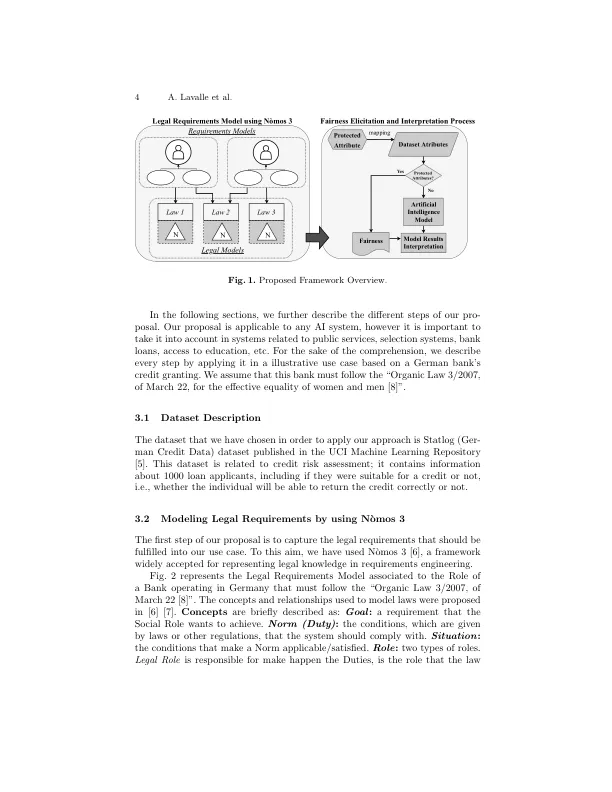

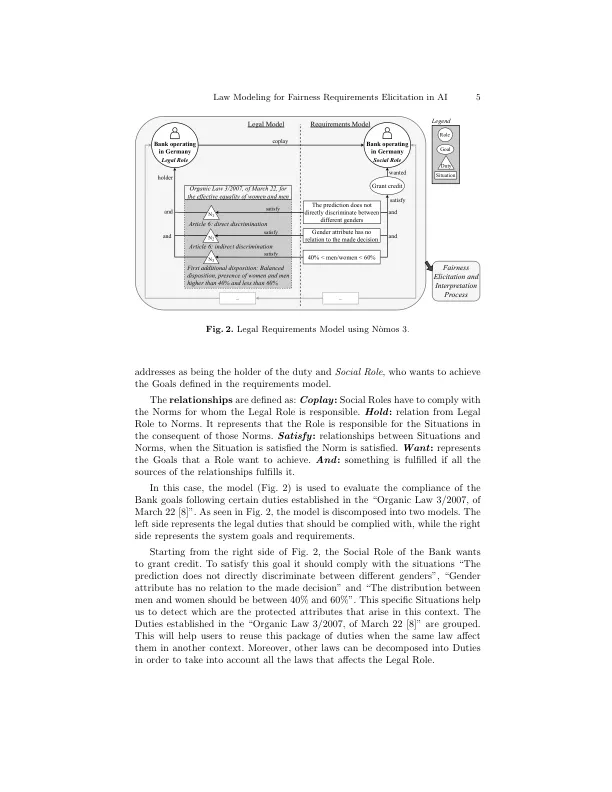

摘要。随着人工智能 (AI) 算法的普及,人们开始担心它们可能会利用种族、性别或年龄等受保护的属性进行歧视。公平是社会高度期望的品质,然而,实现公平却非常困难。识别受保护的属性并努力保持公平是一项重要而又具有挑战性的任务。在本文中,我们提出了一个动态框架,该框架将项目背景与法律建模一起考虑,以识别威胁 AI 模型公平性的受保护属性。这导致对开发的 AI 解决方案的准确性和公平性进行有意识的评估。为此,我们建议使用 N`omos 3 对法律要求进行建模,这使我们能够将应满足的法律要求捕获到可以加载到我们框架中的法律背景中。根据我们的建议,我们可以 (i) 将法律要求中的职责映射到所用数据集中的属性,识别受保护的属性并提供可追溯性,(ii) 帮助用户选择最适合当前情况的公平性定义,(iii) 以视觉方式表示 AI 模型的输出,以便用户解释模型做出的决策的正确性和公平性。为了展示我们建议的适用性,我们通过一个说明性用例来举例说明其应用。

公平要求的法律建模引出...

主要关键词