机构名称:

¥ 1.0

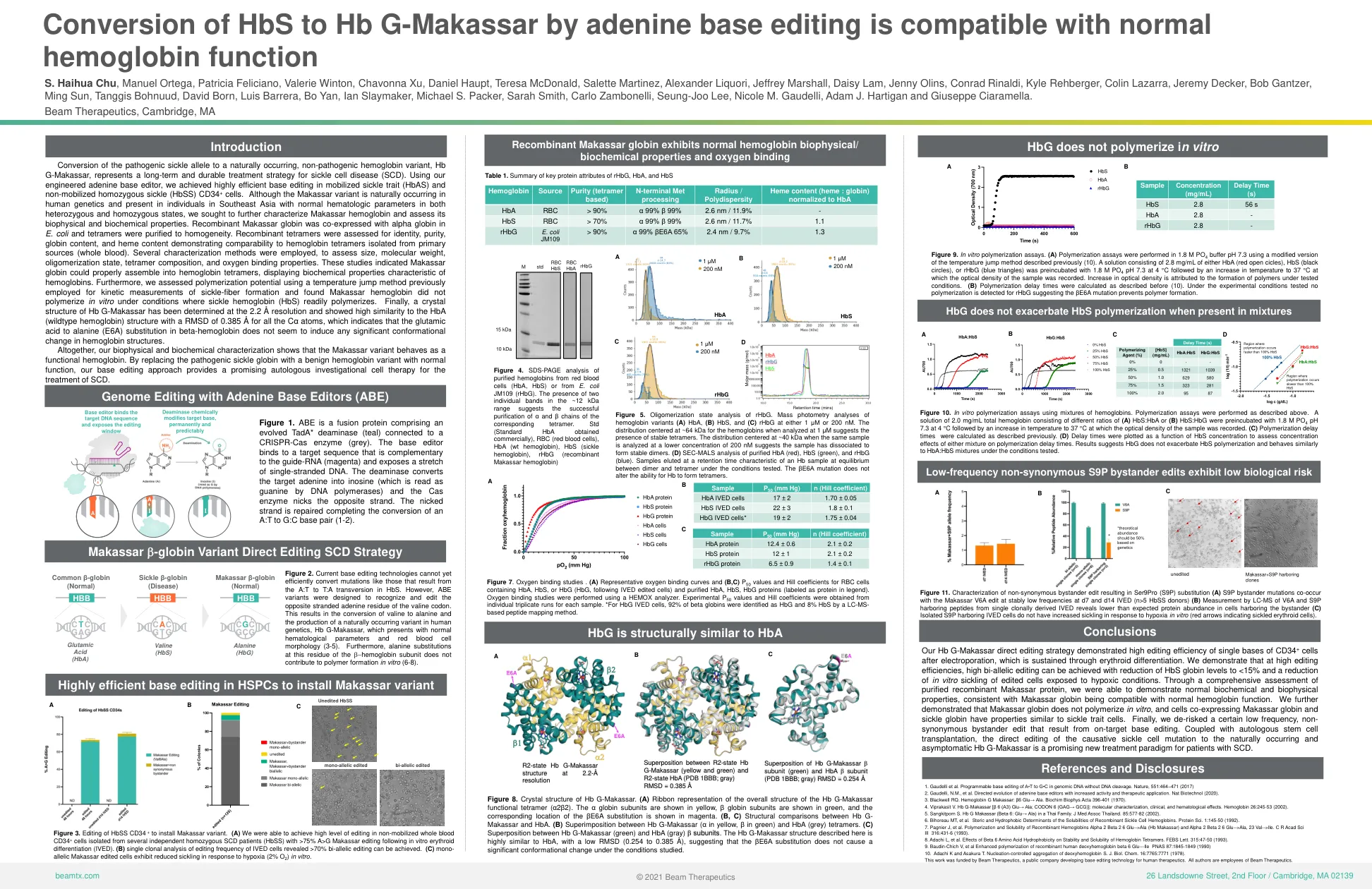

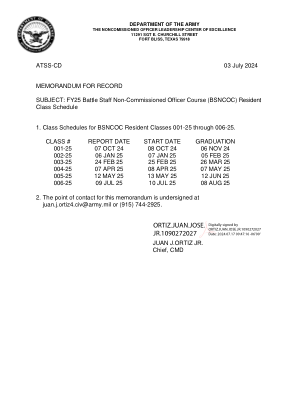

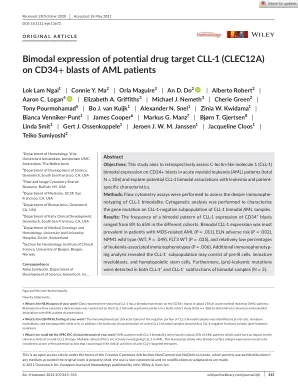

医学图像分析中深度学习的核心挑战之一是数据不足,尤其是对于3D脑成像,这可能会导致模型过度拟合和泛化。正规化策略(例如知识蒸馏)是通过惩罚预测性分布并引入其他知识来加强培训过程的强大工具来减轻问题。在本文中,我们通过惩罚细心的产出分布和中间代表来重新审视知识扭曲作为正规化范式。尤其是我们提出了一个信心正规知识蒸馏(CREG-KD)框架,该框架可以根据知识信心自适应地转移知识以进行蒸馏。提倡两种策略,以使教师和学生知识之间的全球和地方依赖性正规化。详细提出了一种封闭式的蒸馏机制,以通过将教师损失作为置信度得分来软化全球转移的知识。中间表示非常专心和局部完善,具有关键的摩西环境,以模仿有意义的特征。为了证明我们提出的框架的优越性,我们评估了两个大脑成像分析任务的框架(即基于阿尔茨海默氏病的疾病分类和大脑年龄估计,基于阿尔茨海默氏病神经影像学计划数据集,包括902名受试者和来自4个公共数据集的3655名受试者的同类。广泛的实验结果表明,CREG-KD比基线教师模型取得了一致的改进,并表现出了其他最先进的知识蒸馏方法,这表明Creg-KD是有希望的预测性能和普遍性的强大医学图像分析工具。

CD-KDCD-KD

主要关键词