机构名称:

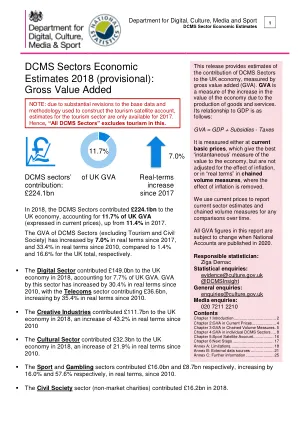

¥ 2.0

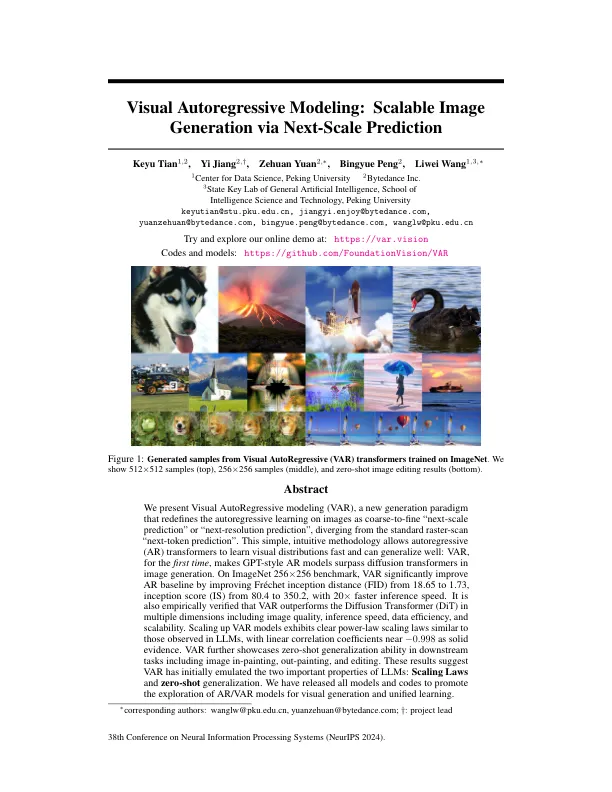

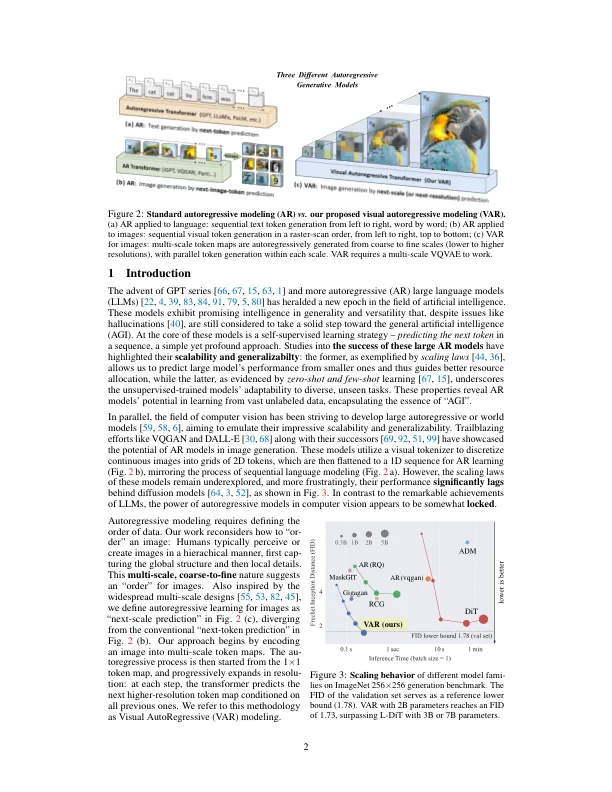

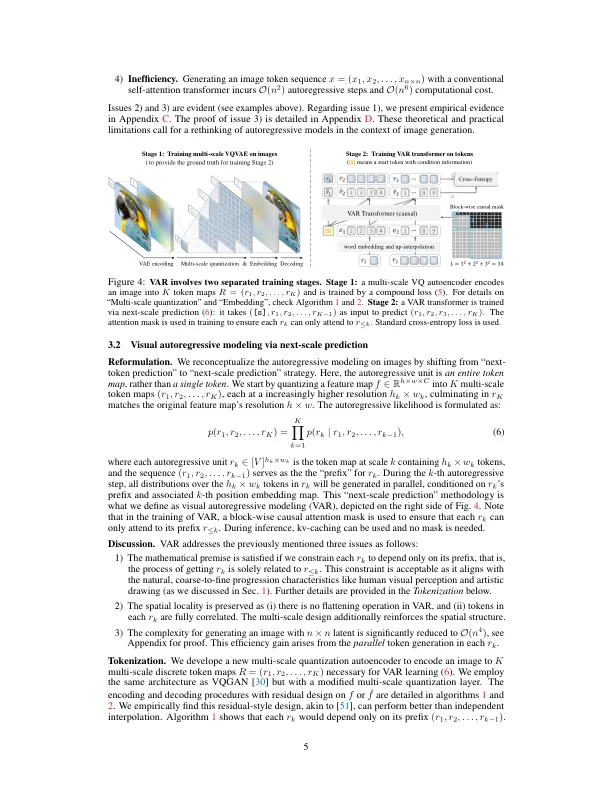

我们提出了视觉自动回归建模(VAR),这是一种新一代范式,它重新定义了图像上的自回归学习,例如粗到精细的“下一尺度预测”或“下一个分辨率预测”,与标准的栅格扫描“下一步的预测”不同。这种简单,直观的方法使自动回归(AR)变压器可以快速学习视觉分布并可以很好地概括:VAR首次使GPT型AR模型超过图像生成中的扩散变形金刚。在Imagenet上256×256基准上,通过将Fréchet距离(FID)从18.65提高到1.73,从80.4到350.2显着改善了AR基线,并具有20倍的推理速度。还经过经验验证,VAR在多个维度上胜过扩散变压器(DIT),包括图像质量,推理速度,数据效率和可扩展性。扩展VAR模型表现出与LLMS中观察到的明确的幂律缩放定律,线性相关系数接近-0。998作为可靠的证据。var进一步展示了下游任务中的零弹性概括能力,包括图像上涂抹,外观和编辑。这些结果表明,VAR最初模拟了LLM的两个重要特性:缩放定律和零弹性概括。我们发布了所有模型和代码,以促进对视觉生成和统一学习的AR/VAR模型的探索。

可扩展图像通过临时预测

主要关键词