机构名称:

¥ 2.0

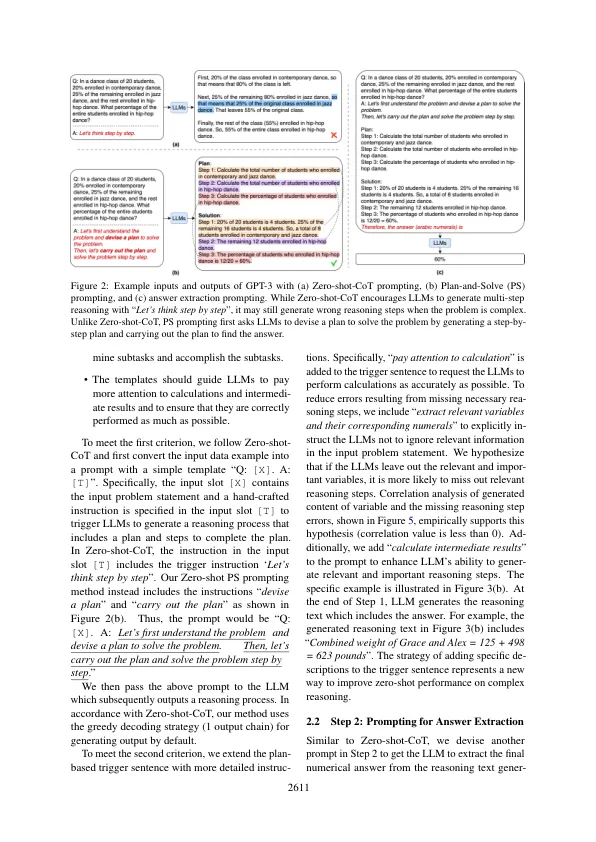

大型语言模型 (LLM) 最近已被证明在各种 NLP 任务中表现出色。为了解决多步骤推理任务,少样本思维链 (CoT) 提示包括一些手工制作的分步推理演示,使 LLM 能够明确生成推理步骤并提高其推理任务准确性。为了消除人工工作,零样本思维链 (CoT) 将目标问题陈述与“让我们一步一步思考”连接起来作为 LLM 的输入提示。尽管零样本思维链 (CoT) 取得了成功,但它仍然存在三个缺陷:计算错误、缺步错误和语义误解错误。为了解决缺步错误,我们提出了计划和解决 (PS) 提示。它由两个部分组成:首先,制定计划将整个任务分成更小的子任务,然后根据计划执行子任务。为了解决计算错误并提高生成的推理步骤的质量,我们扩展了 PS 提示,增加了更详细的说明,并衍生出 PS+ 提示。我们在三个推理问题的十个数据集上评估了我们提出的提示策略。在 GPT-3 上的实验结果表明,我们提出的零样本提示在所有数据集上的表现始终远超零样本 CoT,与零样本思维程序提示相当或超过零样本思维程序提示,并且在数学推理问题上具有与 8 样本 CoT 提示相当的性能。代码可以在 https://github.com/AGI-Edgerunners/Plan-and-Solve-Prompting 找到。

计划和解决提示:改进零样本链......