机构名称:

¥ 2.0

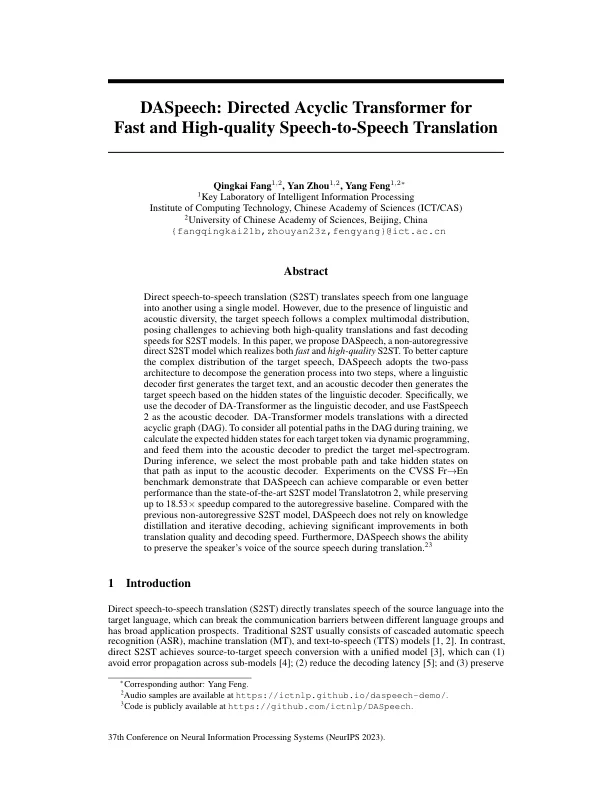

直接语音到语音翻译 (S2ST) 使用单一模型将语音从一种语言翻译成另一种语言。然而,由于语言和声学多样性的存在,目标语音遵循复杂的多模态分布,这对 S2ST 模型实现高质量翻译和快速解码提出了挑战。在本文中,我们提出了 DASpeech,这是一种非自回归直接 S2ST 模型,可实现快速和高质量的 S2ST。为了更好地捕捉目标语音的复杂分布,DASpeech 采用两遍架构将生成过程分解为两个步骤,其中语言解码器首先生成目标文本,然后声学解码器根据语言解码器的隐藏状态生成目标语音。具体而言,我们使用 DA-Transformer 的解码器作为语言解码器,并使用 FastSpeech 2 作为声学解码器。DA-Transformer 使用有向无环图 (DAG) 对翻译进行建模。为了在训练过程中考虑 DAG 中的所有潜在路径,我们通过动态规划计算每个目标 token 的预期隐藏状态,并将它们输入声学解码器以预测目标梅尔频谱图。在推理过程中,我们选择最可能的路径并将该路径上的隐藏状态作为声学解码器的输入。在 CVSS Fr → En 基准上的实验表明,DASpeech 可以实现与最先进的 S2ST 模型 Translatotron 2 相当甚至更好的性能,同时与自回归基线相比保持高达 18.53 倍的加速。与之前的非自回归 S2ST 模型相比,DASpeech 不依赖于知识蒸馏和迭代解码,在翻译质量和解码速度方面都实现了显着提升。此外,DASpeech 还展示了在翻译过程中保留源语音的说话者声音的能力。23

DASpeech:用于快速和高精度的有向非循环变压器......

主要关键词