机构名称:

¥ 1.0

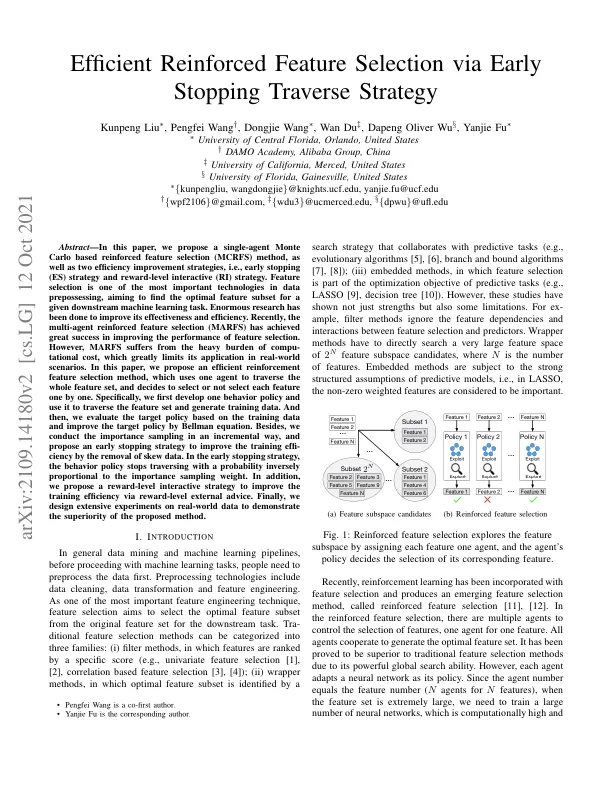

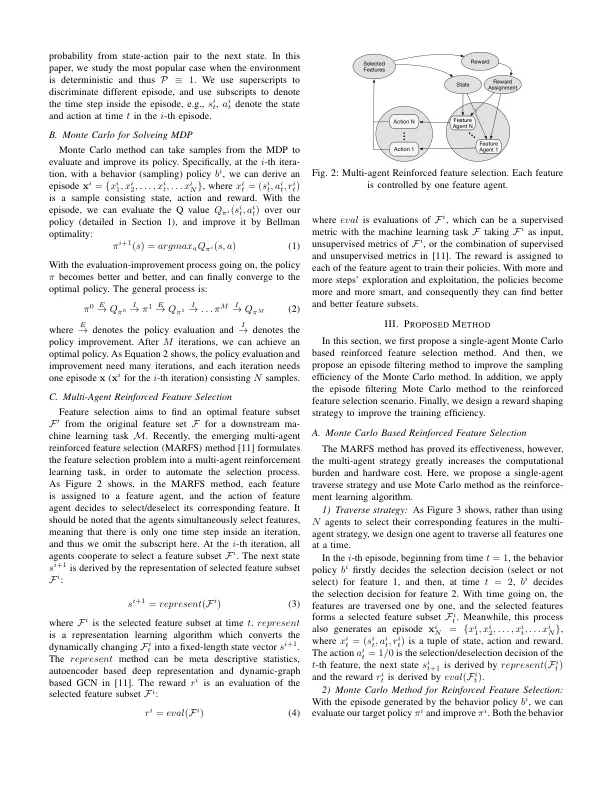

摘要 - 在本文中,我们提出了一种基于蒙特卡洛的增强特征选择(MCRFS)方法,以及两种效率改进策略,即早期停止(ES)策略和奖励级别互动(RI)策略。功能选择是数据预科技术中最重要的技术之一,旨在为给定的下游机器学习任务找到最佳特征子集。已进行了巨大的研究,以提高其有效性和效率。最近,多代理增强功能选择(MARFS)在改善特征选择的性能方面取得了巨大的成功。但是,Marfs承受着构成成本的沉重负担,这极大地限制了其在现实情况下的应用。在本文中,我们提出了一种有效的增强功能选择方法,该方法使用一种代理来遍历整个功能集,并决定选择或不选择每个功能。特别是,我们首先制定一种行为策略,并使用它来穿越功能集并生成培训数据。然后,我们根据培训数据评估目标策略,并通过Bellman方程来改善目标政策。此外,我们以渐进的方式进行了重要性采样,并提出了一种早期停止策略,以通过删除偏斜数据来提高训练效率。在早期停止策略中,行为策略停止以与重要性抽样重量成反比的概率相反。此外,我们提出了一种奖励级别的互动策略,以通过奖励级别的外部建议来提高培训效率。最后,我们在现实世界数据上设计了广泛的实验,以证明该方法的优越性。

通过早停...

主要关键词