机构名称:

¥ 2.0

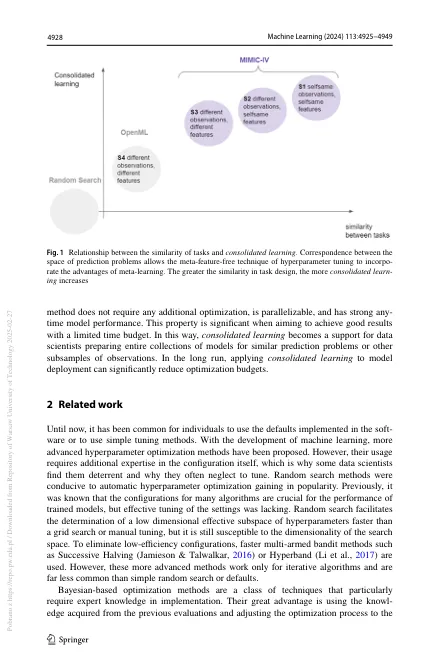

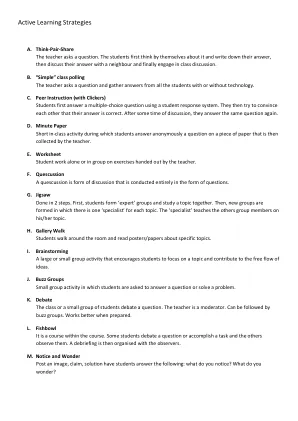

摘要对于许多机器学习模型,超参数的选择是实现高性能的关键一步。普遍的元学习方法集中于根据从先前任务中获得的结果获得有限的计算预算,以有限的计算预算获得良好的高参数配置。本文提出了调整问题的新形式,称为合并学习,更适合于模型开发人员面临的实用挑战,其中在类似的数据集中对大量的预测模型进行了处理。在这种设置中,我们对总优化时间感兴趣,而不是为单个任务调整。我们表明,精心选择的静态参数配置的静态组合可为任何时间优化带来良好的结果,同时既可以易于使用和实现。此外,我们指出了如何为特定域构建这样的投资组合。由于相似任务之间的超参数配置更有效地传递了优化的改进。我们通过对Xgboost Algo-Rithm的经验研究以及从MIMIC-IV医学数据库中提取的预测任务的新创建的基准基准来揭示这种方法的有效性。在论文中,我们表明,由于与许多机器学习应用方案的兼容性,合并学习的潜力要大得多。

合并学习:一种特定领域的无模型优化策略,并在元基准上进行验证

主要关键词