机构名称:

¥ 1.0

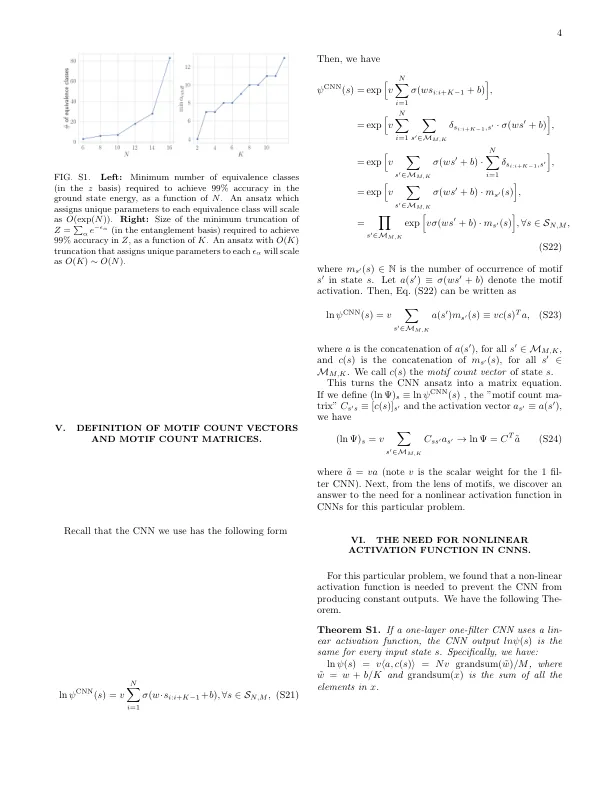

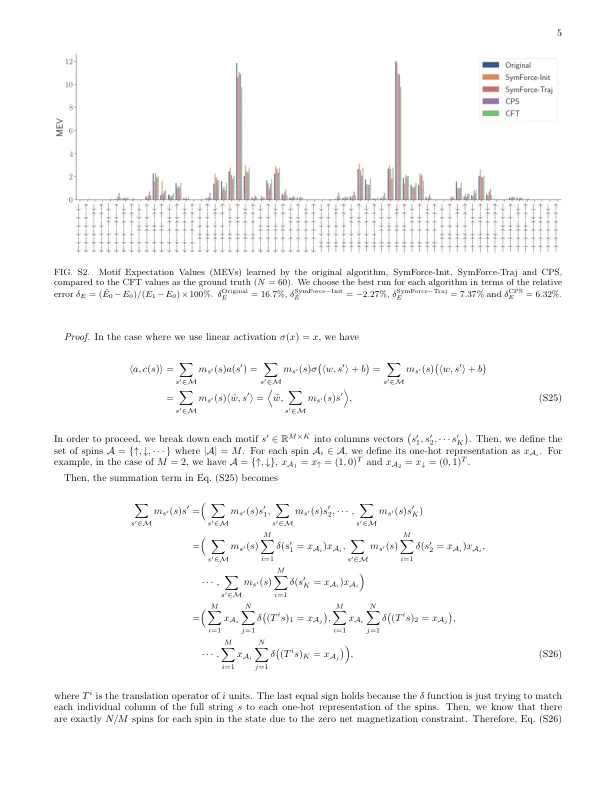

Rameters:内核大小k∈{3,6,12,24},学习率η∈{0。0001,0。001},在训练nopt∈{10,100}期间重复使用相同的VMC样品的迭代次数和训练算法a∈{原始,深(L层),Symforce-Init,Symforce-traj}。对于a∈{原始的,symforce-init,symforce-traj},我们使用l = f = 1,其中l表示CNN层的数量,F表示CNN过滤器的数量。,当a = deep(l层)时,我们遵循[1]进行f和l的选择。我们使用l∈{2,3,8}。对于2层CNN,我们使用f∈{1,8,16},对于更深的CNN,我们使用f∈{8,16}。对于超参数调整,我们通过设置张量[2]和numpy [3]的隆起种子来运行每个设置5次,并使用不同的随机初始化。收集实验结果后,我们首先删除在5个运行中的任何一个中引起差异的Hy-Perparameter设置。然后,对于每个(a,l,k),我们选择导致基态能量相对误差的最小绝对值的超级反感器。

补充材料

主要关键词