机构名称:

¥ 1.0

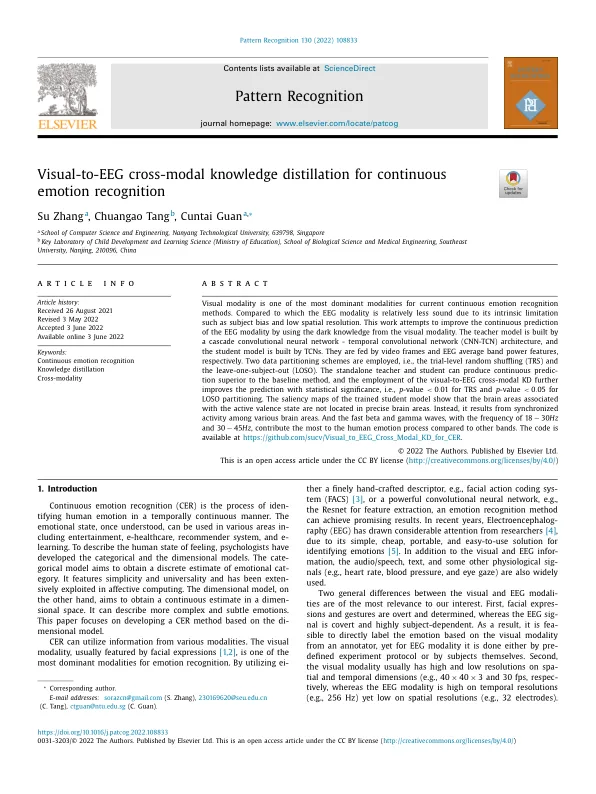

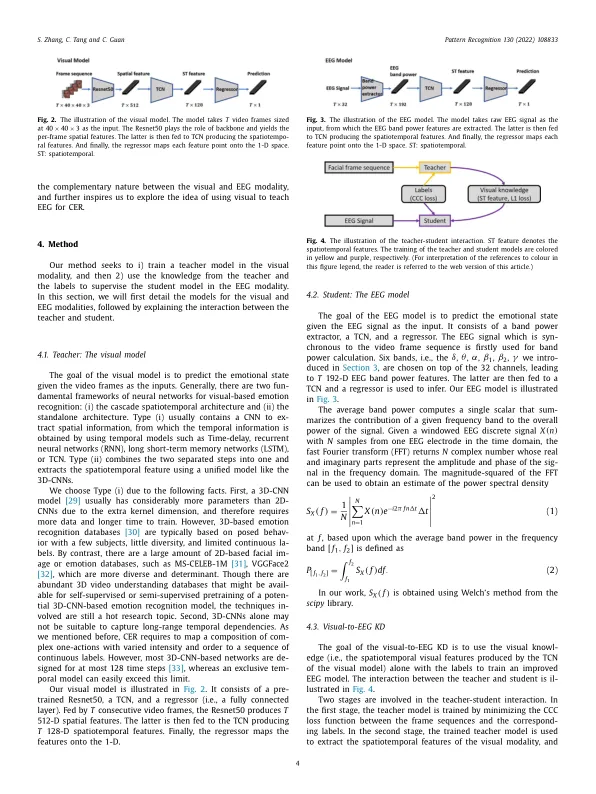

视觉模态是当前连续情绪识别方法中最主要的模态之一。与视觉模态相比,EEG 模态由于其固有的局限性(例如主体偏见和低空间分辨率)而相对不太可靠。这项工作尝试利用来自视觉模态的暗知识来改善 EEG 模态的连续预测。教师模型由级联卷积神经网络-时间卷积网络 (CNN-TCN) 架构构建,学生模型由 TCN 构建。它们分别由视频帧和 EEG 平均频带功率特征输入。采用两种数据划分方案,即试验级随机分流 (TRS) 和留一主体剔除 (LOSO)。独立的老师和学生可以产生优于基线方法的连续预测,并且使用视觉到 EEG 跨模态 KD 进一步改善了预测,具有统计显著性,即 TRS 的 p 值 < 0.01 和 p 值 < 0。 05 用于 LOSO 分区。训练后的学生模型的显着性图显示,与活跃价态相关的大脑区域并不位于精确的大脑区域。相反,它来自各个大脑区域之间的同步活动。与其他波段相比,频率为 18 − 30 Hz 和 30 − 45 Hz 的快速 beta 和 gamma 波对人类情绪过程的贡献最大。代码可在 https://github.com/sucv/Visual _ to _ EEG _ Cross _ Modal _ KD _ for _ CER 获得。

视觉到脑电图跨模态知识提炼,实现持续情绪识别

主要关键词