机构名称:

¥ 1.0

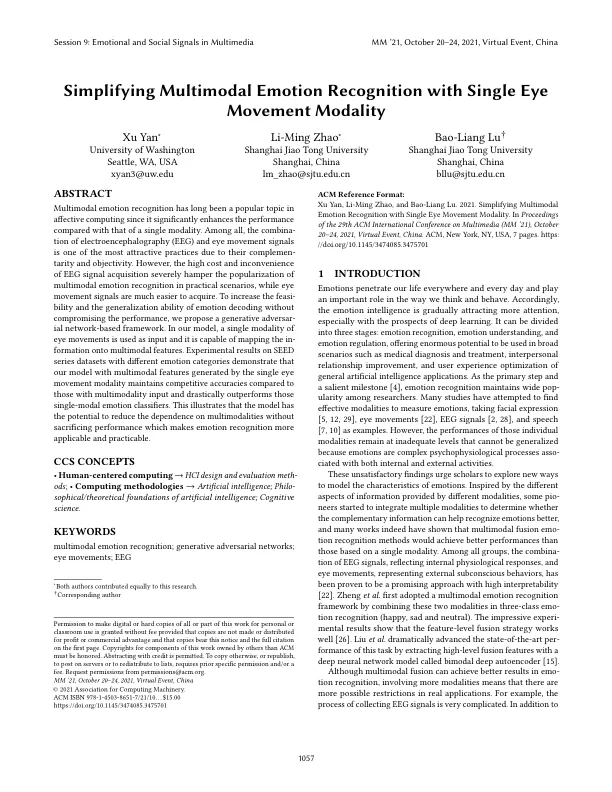

多模态情绪识别一直是情感计算的热门话题,因为与单一模态相比,它能显著提高识别性能。其中,脑电图 (EEG) 和眼动信号的组合由于它们的互补性和客观性而成为最有吸引力的实践之一。然而,脑电图信号采集的高成本和不便性严重阻碍了多模态情绪识别在实际场景中的普及,而眼动信号则更容易获取。为了在不影响性能的情况下提高情绪解码的可行性和泛化能力,我们提出了一个基于生成对抗网络的框架。在我们的模型中,单一模态的眼动作为输入,它能够将信息映射到多模态特征上。在不同情绪类别的 SEED 系列数据集上的实验结果表明,与使用多模态输入的模型相比,使用单一眼动模态生成的多模态特征的模型保持了具有竞争力的准确率,并且大大优于那些单模态情绪分类器。这说明该模型有可能在不牺牲性能的情况下减少对多模态的依赖,从而使情绪识别更具适用性和实用性。

利用单眼动模式简化多模态情绪识别

主要关键词