机构名称:

¥ 1.0

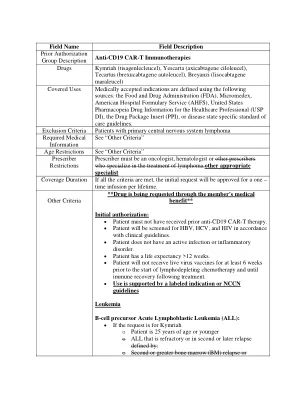

持续学习 (CL) 的目标是随着时间的推移学习不同的任务。与 CL 相关的主要需求是保持旧任务的表现,利用后者来改进未来任务的学习,并在训练过程中引入最小的开销(例如,不需要增长模型或重新训练)。我们提出了神经启发稳定性-可塑性适应 (NISPA) 架构,通过固定密度的稀疏神经网络解决这些需求。NISPA 形成稳定的路径来保存从旧任务中学到的知识。此外,NISPA 使用连接重新布线来创建新的可塑性路径,以便在新任务上重用现有知识。我们对 EMNIST、FashionM-NIST、CIFAR10 和 CIFAR100 数据集的广泛评估表明,NISPA 的表现明显优于具有代表性的最先进的持续学习基线,并且与基线相比,它使用的可学习参数减少了十倍。我们还认为稀疏性是持续学习的必要因素。NISPA 代码可在 https://github.com/BurakGurbuz97/NISPA 上找到

NISPA:受神经启发的稳定性-可塑性适应,用于稀疏网络中的持续学习

主要关键词