机构名称:

¥ 1.0

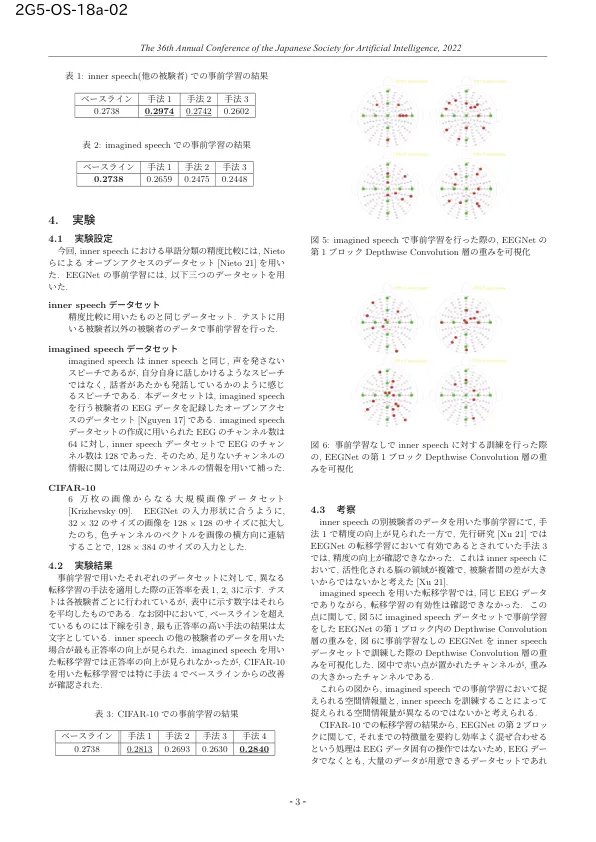

内在语言是一种内化的语言,人们用这种语言思考纯粹的意义。从大脑活动数据中解码内在语言不仅可以促进残障患者的交流,还可以帮助健康人整理思路,提高对元认知的理解。在之前的研究中,一种名为 EEGNet 的 EEG 数据深度学习模型被用于内在语言解码。然而,它在 4 类分类任务中只达到了 30% 的准确率。数据稀缺和内在语言解码固有的难度可能是原因,但这项研究假设以前的研究中特征提取不足。为了提高解码内在语言的准确性,使用迁移学习被认为是更有效的;在这种学习中,模型事先在不同的数据集上进行训练,然后针对目标数据进行微调。然而,迁移学习尚未应用于内在语言,甚至尚未应用于 EEG 数据。迁移学习对不同任务的脑电图数据或非脑电图数据的有效性尚未得到充分验证。本研究通过使用不同任务的脑电图数据和非脑电图数据对公开的内部语音数据集进行迁移学习,验证了特征提取的改进。结果证实,使用来自不同受试者的数据的迁移学习可以提高内部语音的准确性,但使用来自不同任务的脑电图数据的迁移学习则不会。另一方面,对于图像数据集,通过冻结某些层可以确认准确性的提高,即使数据的性质与脑电图数据不同。

使用预先训练的深度学习模型对 EEG 数据进行内部学习......

主要关键词