机构名称:

¥ 1.0

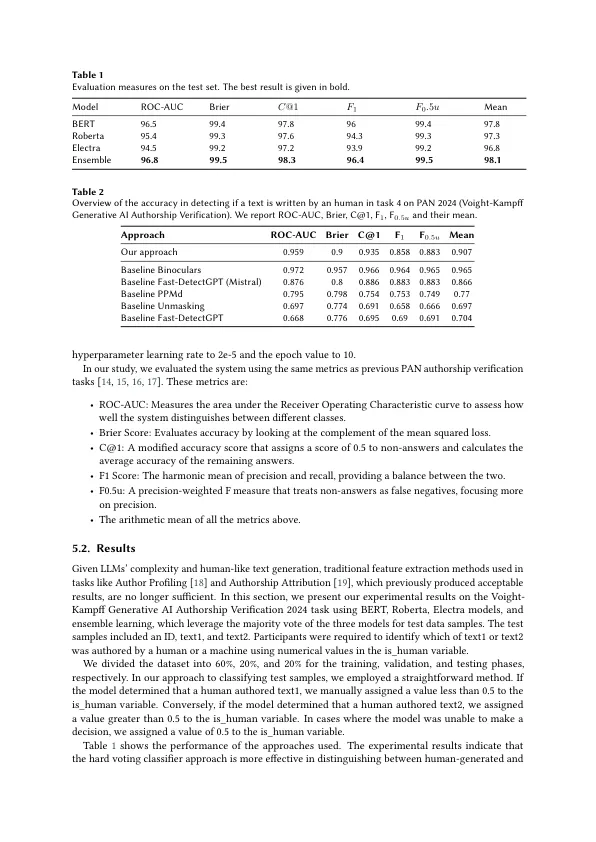

LLM的最新进展,尤其是随着GPT-3.5和GPT-4等复杂系统的开发,从广告和新闻写作到教育和医学研究的各个领域的内容创建彻底改变了跨各个领域的内容。这些模型现在能够生成紧密模仿人写作的文本,并在众多专业工作流程中提高生产力。但是,这种快速的整合面临着重大挑战,包括错误信息[1],伦理困境[2]和学术完整性问题[3,4,5]。LLM产生高度令人信服但可能具有误导性或不准确的内容的能力引起了人们对滥用假新闻,欺骗性社交媒体帖子的滥用的担忧,甚至促进了学术不诚实[6]。因此,开发可靠的方法来区分人类作品和机器生成的文本以减轻这些风险并确保负责使用LLMS变得越来越重要。应对这些挑战,PAN@CLEF 2024引入了Voight-Kampff Generative AI作者身份验证任务。对AI生成的文本的检测已成为研究的关键领域,这是由于需要维护跨数字平台的信息的完整性。传统的文本验证方法在很大程度上依赖于风格和语言特征,当面对现代LLM的精致时,通常不足。这些模型可以生成内容,不仅反映了人类写作,还可以适应各种上下文和样式,从而使手动甚至某些自动检测方法过时。因此,需要更先进的技术来有效地区分人类作者和机器生成的文本。在这项研究中,最初,我们使用培训数据集微调了变压器模型。此过程涉及调整模型参数以更好地符合数据集的特定特征,从而改善模型在我们特定任务上的性能。然后,我们将其准确性与累积学习模型的准确性进行了比较。结果表明合并累积学习模型

PAN LAB的笔记本2024

主要关键词