机构名称:

¥ 1.0

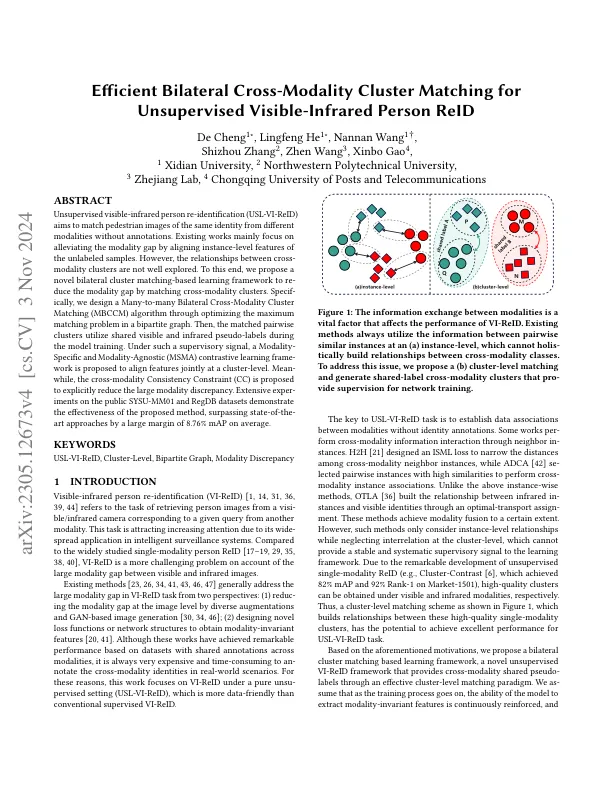

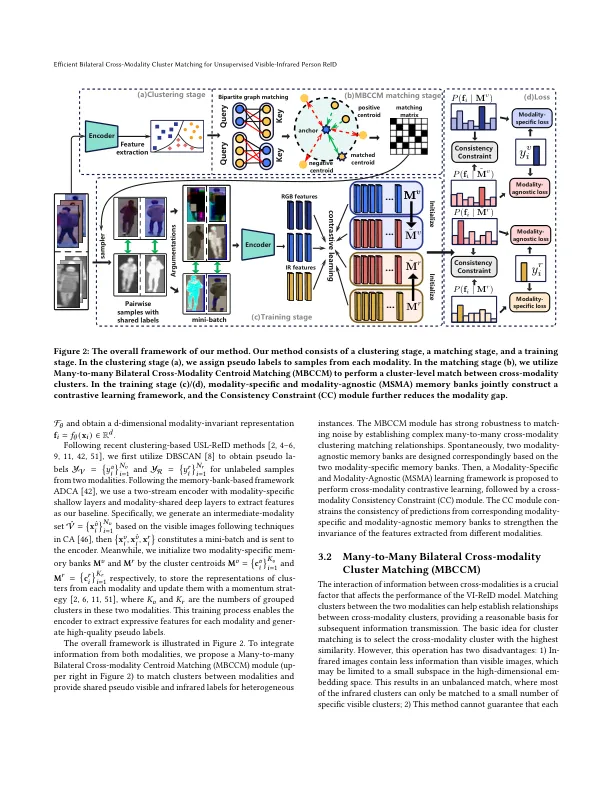

无监督的可见红外人员重新识别(USL-VI-REID)旨在匹配来自不同方式的同一身份的行人图像,而无需注释。现有作品主要集中于通过对齐未标记的样本的实例级特征来减轻模式差距。但是,跨模式簇之间的关系尚未得到很好的探索。为此,我们提出了一个新型的双边群集匹配的学习框架,以通过匹配的跨模式簇来弥补模态差距。特定的是,我们通过优化两部分图中的最大匹配问题来设计多到多的双边跨模式群匹配(MBCCM)算法。然后,匹配的成对簇在模型训练过程中利用共享的可见和红外伪标签。在这样的监督信号下,提出了一种特异性和模态性和情态的(MSMA)对比度学习框架 - 提议在集群级别上共同对齐特征。平均值,提出了交叉模式一致性约束(CC),以明确减少较大的模态差异。对公共SYSU-MM01和REGDB数据集进行了广泛的实验,证明了该方法的有效性,平均超过8.76%的地图超过了最先进的方法。

有效的双边跨模式群集匹配无监督的可见红外人Reid

主要关键词