机构名称:

¥ 1.0

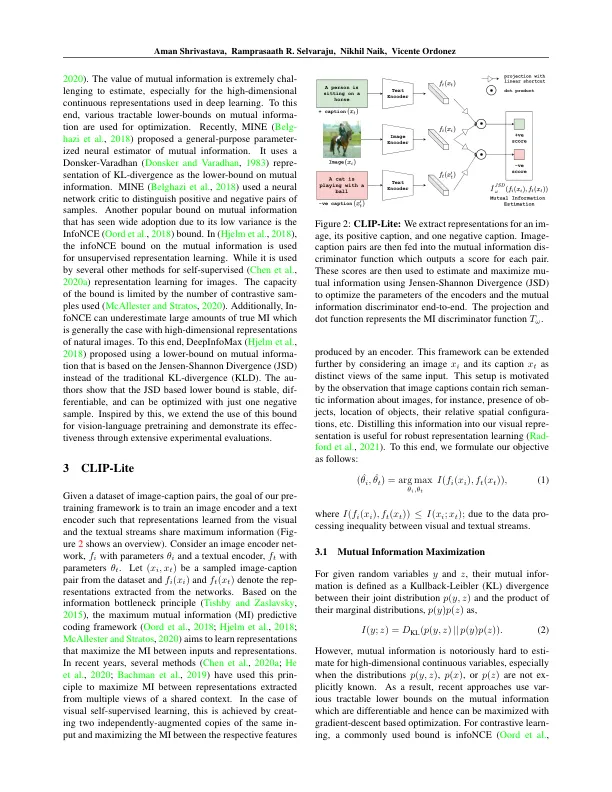

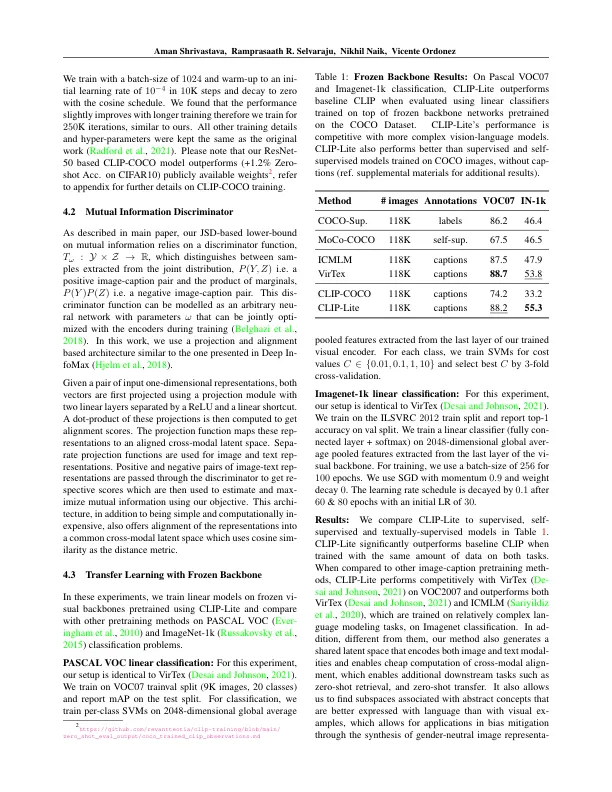

我们提出了夹子 - 列表,这是一种通过文本注释来进行视觉表示学习的信息有效方法。与先前提出的剪辑模型相结合,在优化其对比度学习目标的过程中,夹子夹仅需要一个负面图像文本样本对。我们通过提高信息有效下限的优势来实现这一目标,以最大程度地提高两种输入方式之间的相互信息。这允许在相同尺度上比夹子相比,可以通过显着摄入的数据和批量大小进行培训。我们通过在可可扣数据集上进行预处理并测试向其他数据集的转移学习来评估夹列。夹子夹在Pascal VOC分类中获得了 +14.0%的MAP绝对增益,并且在Imagenet上获得了 +22.1%的TOP-1准确性增益,同时是合并或优于其他,更复杂,更复杂的文本监督模型。夹子夹也可以夹在图像和文本检索,零拍零分类和视觉接地上。fi-Nelly,我们表明夹具可以利用语言语义来鼓励可以在下游任务中使用的无偏见的视觉表示。实现:https:// github。com/4m4n5/clip-lite

剪贴画:通过语言监督的信息有效的视觉表示学习