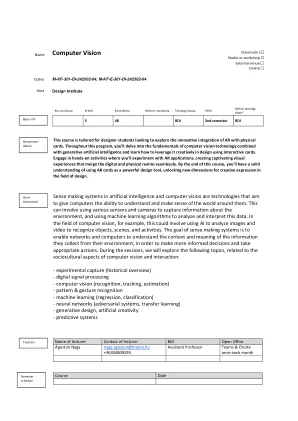

机构名称:

¥ 2.0

在为人提供服务时,机器人需要优化与最终用户偏好保持一致的奖励。由于机器人将依靠原始的感知输入,因此他们的奖励将不可避免地使用视觉表示。最近,使用预训练的视觉模型的表示形式引起了人们的兴趣,但是在机器人技术中使这些工作的关键是微调的,这通常是通过动力学预测或执行时间周期矛盾的代理任务来完成的。但是,所有这些代理任务绕过了人类对他们重要的事物的输入,加剧了弹性相关性,并最终导致行为与用户偏好不一致。在这项工作中,我们建议机器人应利用人类的反馈将其视觉表示与最终用户保持一致,并解散该任务的内容。我们提出了representation-基于P参考的L奖(RAPL),这是一种通过基于偏好的学习和最佳运输的镜头来解决视觉表示对准问题和视觉奖励学习问题的方法。在X魔术和机器人手术中的实验中,我们发现Rapl的奖励始终产生具有较高样品效率的首选机器人行为,并在从不同的体现中学到与机器人的实现时显示出强烈的零光概括。

视觉表示对齐

主要关键词