机构名称:

¥ 1.0

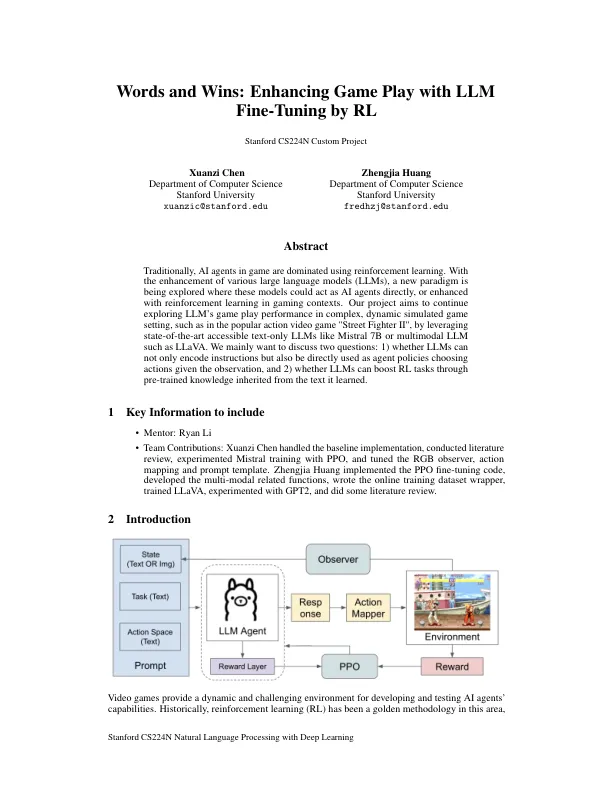

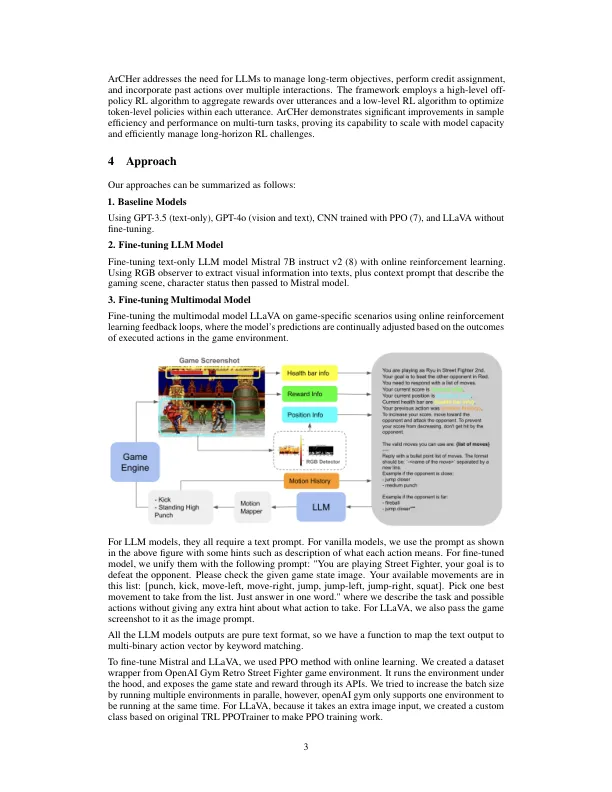

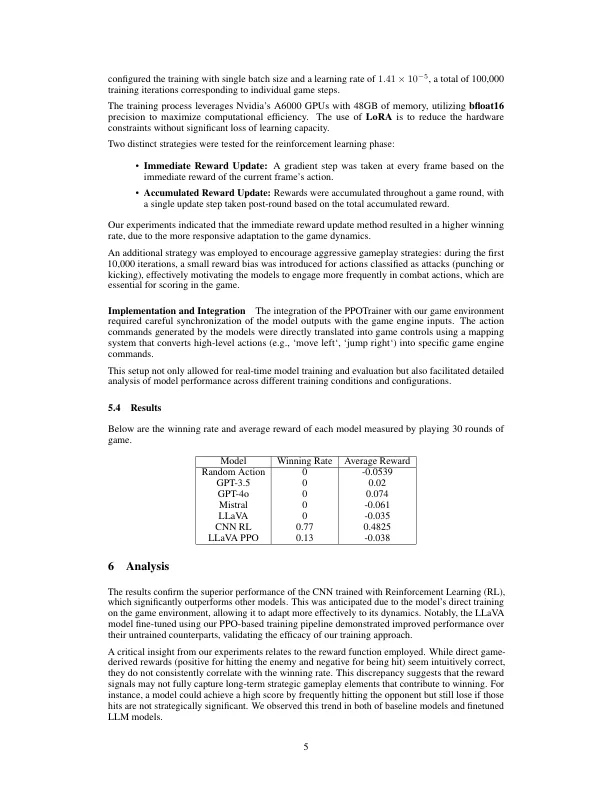

传统上,游戏中的AI代理是使用加强学习主导的。随着各种大型语言模型(LLM)的增强,正在探索一个新的范式,这些模型可以直接充当AI代理,或者在游戏环境中通过增强学习增强。我们的项目旨在通过利用诸如流行的动作视频游戏“ Street Fighter II”(例如,利用Mistral 7B或Multomodal LLM)等最新的可访问的仅访问的文本LLM,例如在流行的动作视频游戏“ Street Fighter II”中继续探索LLM的游戏玩法表现。我们主要想讨论两个问题:1)LLM是否不仅可以编码指令,而且还可以直接用作鉴于观察结果的行为的代理策略,以及2)LLMS是否可以通过从所学文本中继承的预训练的知识来促进RL任务。

幻灯片