机构名称:

¥ 1.0

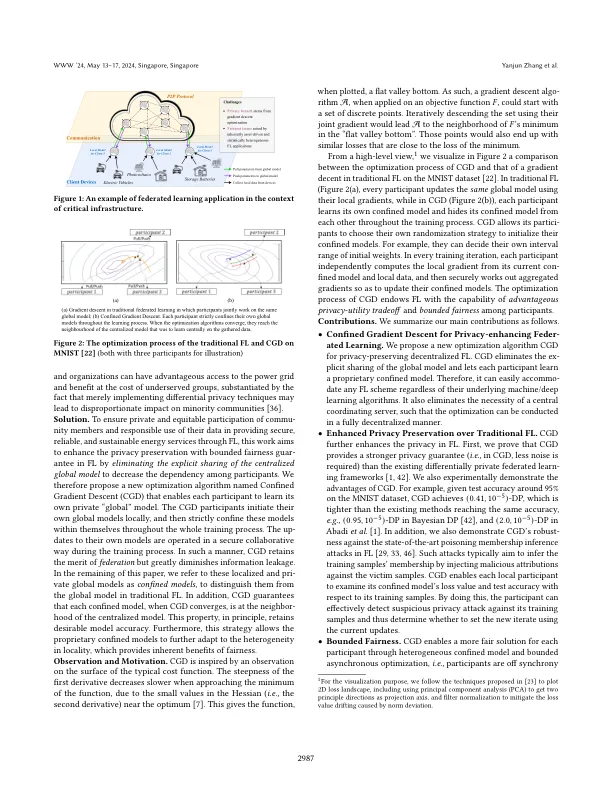

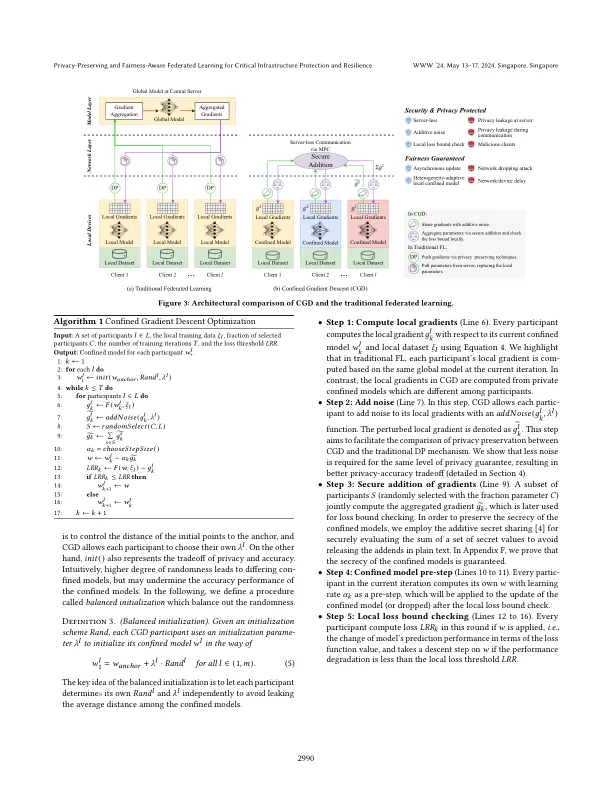

能源行业正在经历重大转型,致力于实现净零排放并使其基础设施面向未来,电网中的每个参与者都有可能消耗和生产能源资源。联邦学习 - 使多个参与者能够协作训练模型而无需汇总训练数据 - 成为一种可行的技术。然而,必须共享以进行优化的全局模型参数仍然容易受到训练数据泄露的影响。在这项工作中,我们提出了受限梯度下降(CGD),通过消除全局模型参数的共享来增强联邦学习的隐私性。CGD利用了这样一个事实:梯度下降优化可以从一组离散点开始,并收敛到目标函数全局最小值邻域中的另一组点。因此,每个参与者可以独立地启动自己的私有全局模型(称为受限模型),并协作学习以达到最优值。在训练过程中,他们自己的模型的更新以安全的协作方式进行。通过这种方式,CGD 保留了从分布式数据中学习的能力,但大大减少了信息共享。这种策略还允许专有的受限模型适应联邦学习中的异质性,从而提供公平性的内在优势。我们从理论和经验上证明,分散式 CGD(i)提供更强大的差异隐私(DP)保护;(ii)对最先进的毒害隐私攻击具有鲁棒性;(iii)导致参与者之间的有限公平性保证;(iv)在四个真实世界数据集上提供高测试准确率(与集中式学习相当)和有界收敛率。

隐私保护和公平意识联合学习,用于关键基础设施的保护和恢复

主要关键词