机构名称:

¥ 2.0

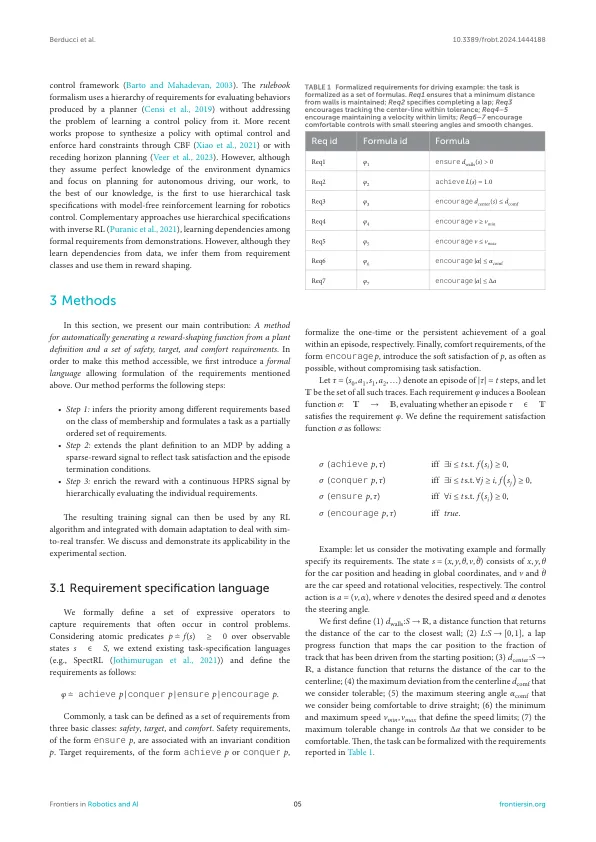

通过强化学习来自动综合机器人系统的政策,依赖于奖励信号并密切指导。因此,该信号应忠实地反映出设计师的意图,这些意图通常被表示为高级要求的集合。几项工作正在从正式要求中开发自动奖励定义,但是它们在产生既有有效培训又能够满足多种异质要求的信号时表现出局限性。在本文中,我们将任务定义为一组部分安全,目标和舒适性要求,并引入一种自动化方法,以在奖励信号中执行自然秩序。我们通过将要求自动转化为安全性,目标和舒适性奖励的总和来执行此操作,其中目标奖励是安全奖励的函数,而舒适奖励是安全和目标奖励的函数。使用基于潜在的公式,我们增强了稀疏到密集的奖励,并正式证明了这一点以保持政策最佳性。我们称我们的新方法分层,基于潜在的奖励成型(HPRS)。我们对八个机器人基准测试的实验表明,HPRS能够生成满足复杂层次要求的政策。此外,与最新技术相比,HPR相对于保留职位的政策评估指标,达到了更快的融合和卓越的性能。通过自动平衡竞争要求,HPRS可以通过改进的舒适度和无手动参数调整生成任务满意的政策。通过消融研究,我们分析了各个需求类别对紧急行为的影响。我们的实验表明,当与目标和安全保持一致时,HPR从舒适性要求中受益,并且在与安全或目标要求冲突时会忽略它们。最后,我们验证了HPRS在现实世界机器人技术应用中的实际可用性,包括使用第1辆车的两个SIM到现实实验。这些实验表明,任务规范的层次设计有助于SIM到现实的传输,而无需任何领域的适应性。

HPRS:从任务规格

主要关键词