机构名称:

¥ 3.0

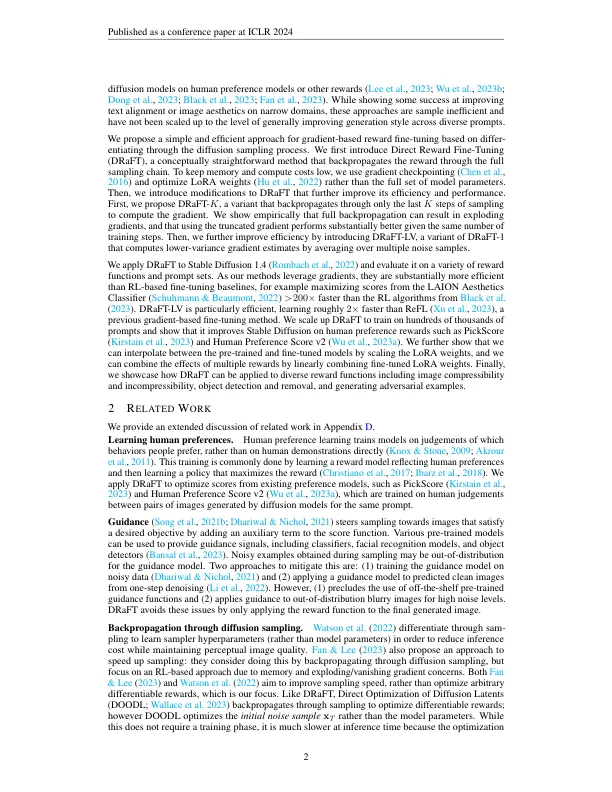

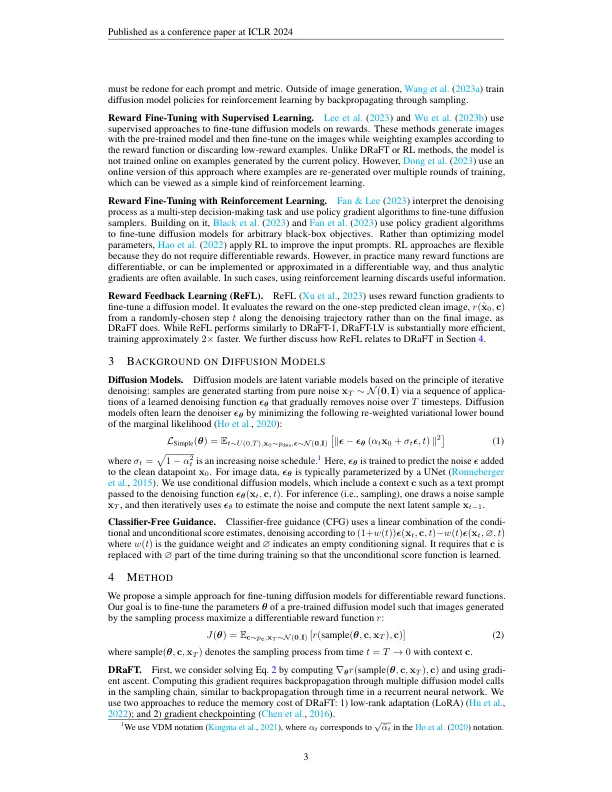

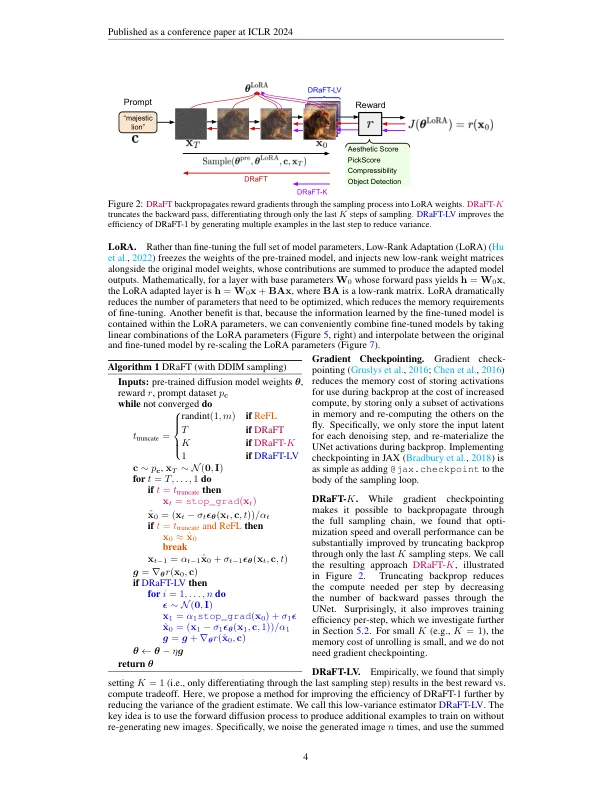

我们提出了直接的奖励微调(草稿),这是一种简单有效的方法,用于调整扩散模型,以最大程度地提高可区分的奖励功能,例如人类偏好模型的分数。我们首先表明,可以通过完整的抽样程序将奖励函数梯度进行后退,并且这样做可以在各种奖励上实现强劲的绩效,超过了基于强化学习的方法。然后,我们提出了草稿:草稿K的更多有效变体,该变体仅将反向传播截断为采样的最后K步骤,而Draft-LV则获得了k = 1时的较低差异梯度估计。我们表明,我们的方法在各种奖励功能上都很好地工作,可以用来实质上提高稳定扩散1.4产生的图像的美学质量。最后,我们在方法和先前的工作之间建立了联系,从而提供了基于基于梯度的细胞调整算法的设计空间的统一观点。

DIF

主要关键词