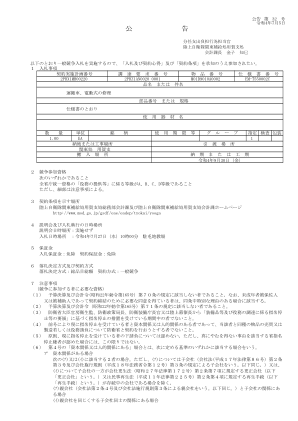

机构名称:

¥ 1.0

他们使用类比来解释为什么它仅仅是一种极端的假设情况,而不是实际的威胁,花了大量时间来进行解释。经常被用来证明对AI构成的存在威胁的恐惧的一种思想实验是“造纸最大化器”实验。在本实验中,AI系统偶然地消除了人类,以最大程度地提高纸袋生产。在这种情况下,AI认为需要更多资源来生产纸卷,并意识到人类正在阻碍获得这些资源。但是,卡普尔和纳拉亚南认为,这种推理假设AI是强大的,但缺乏对人类遗产的根本关注,这是一个有缺陷的前提。他们认为,这种无意识的文字不是具有某些内置保护措施和更细微的解释过程的现代AI系统的特征。直观的AI(AGI) - 一种比当前正在使用的现代AI更先进的系统 - 应该能够识别这对人类不利,如果需要的话,可以执行该功能。

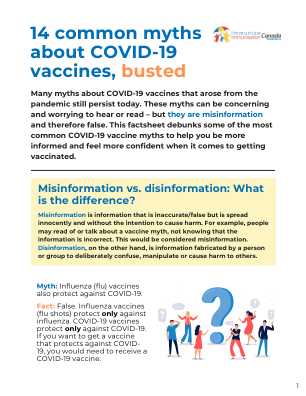

AI上的精美印刷品:揭穿AI神话

主要关键词