机构名称:

¥ 1.0

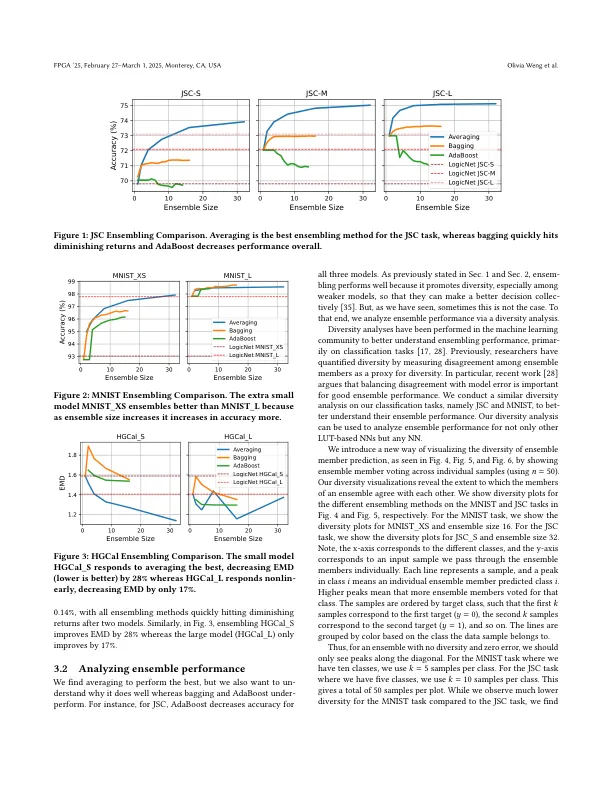

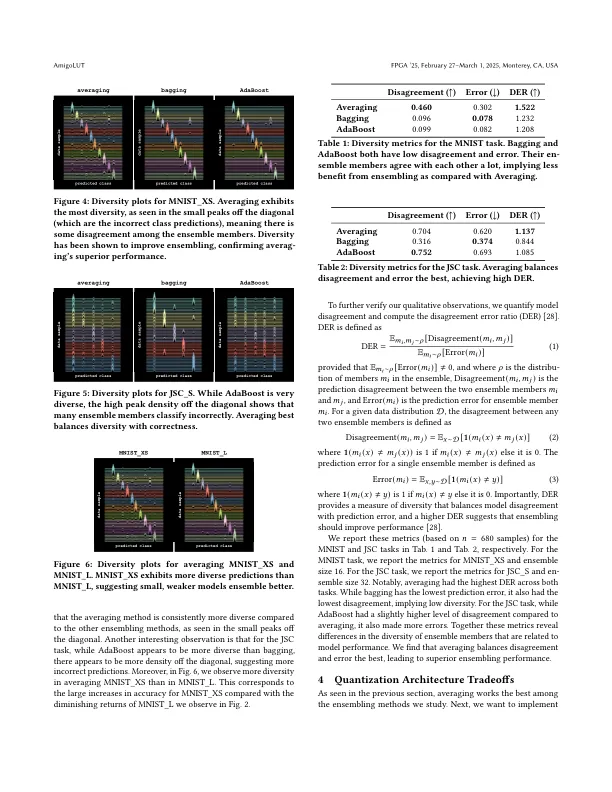

高能物理和网络安全等应用需要极高的吞吐量和低潜伏神经网络(NN)推断。基于查找的NNS通过将NN作为查找表(LUTS)实现,在纳米秒的顺序上实现推理潜伏期来解决这些约束。由于LUTS是一个基本的FPGA构建块,因此基于LUT的NNS有效地映射到FPGA。逻辑(及其继任者)构成了一类基于LUT的NNS,该NN靶向FPGA,将神经元直接映射到LUTS,以满足低潜伏期约束,并以最少的资源来满足低潜伏期的约束。但是,很难构建更大的,更具性能的基于LUT的NN(例如Logicnets),因为LUT使用情况相对于Neu-ron fan-In(即突触×突触×突触位宽度)呈指数增长。一个大的基于LUT的NN迅速在FPGA上耗尽了LUT。我们的工作Amigolut通过创建基于较小的LUT的NNS的合奏来解决此问题,从而相对于模型数量线性扩展。Amigolut提高了基于LUT的NNS的可扩展性,达到更高的吞吐量,而LUTS比最大的基于LUT的NNS少了。

使用Amigolut扩展基于LUT的神经网络

主要关键词