机构名称:

¥ 1.0

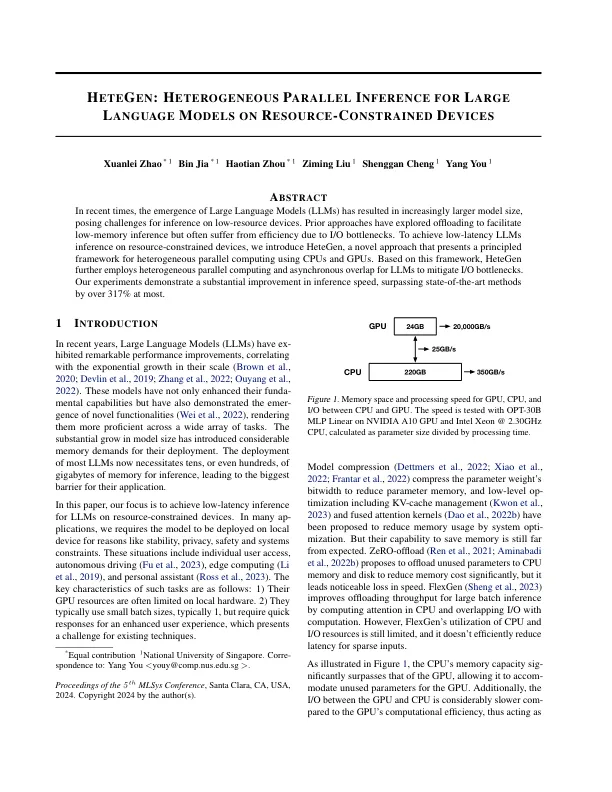

模型压缩(Dettmers等人,2022; Xiao等。,2022; Frantar等。,2022)压缩参数权重以减少参数存储器的位宽和低级操作,包括KV-CACHE管理(Kwon等人,2023年)和融合的注意内核(Dao等人,2022b)已提出通过系统选择来减少记忆使用量。但是,他们节省内存的能力仍然远非预期。零下载(Ren等人,2021; Aminabadi等。,2022b)提议将未使用的参数卸载到CPU内存和磁盘上,以大大降低内存成本,但它导致速度明显损失。flexgen(Sheng等人,2023)通过计算CPU中的注意力和计算重叠I/O中的注意力,改善了大批次推理的卸载吞吐量。但是,FlexGEN对CPU和I/O资源的利用仍然有限,并且不会有效地减少稀疏输入的延迟。

hetegen:在资源约束设备上对大语言模型的异质平行推断