机构名称:

¥ 1.0

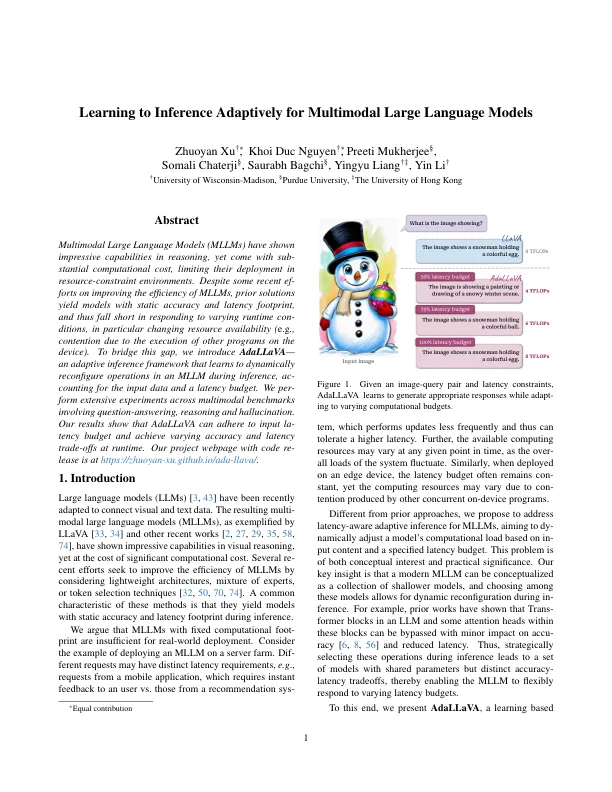

多模式的大语言模型(MLLM)在推理方面表现出了令人印象深刻的功能,但具有基本的计算成本,从而限制了它们在资源构成环境中的部署。尽管最近有一些关于提高MLLM效率的效力,但先前的解决方案产生了具有静态准确性和延迟占地面积的模型,因此在响应不同的运行时条件方面的响应不足,特别是由于设备上其他程序执行其他程序而引起的竞争)。为了弥合这一差距,我们介绍了Adallava - 一种自适应推理框架,该框架学会在推理期间在MLLM中动态重新配置操作,以获取输入数据和延迟预算。我们跨越涉及提问,推理和幻觉的多模式基准进行了广泛的实验。我们的结果表明,Adallava可以遵守输入预算,并在运行时实现不同的准确性和延迟权衡。我们的带代码重新租赁的项目网页位于https://zhuoyan-xu.github.io/ada-llava/。

学习对多模式大语言模型的推论

主要关键词