机构名称:

¥ 1.0

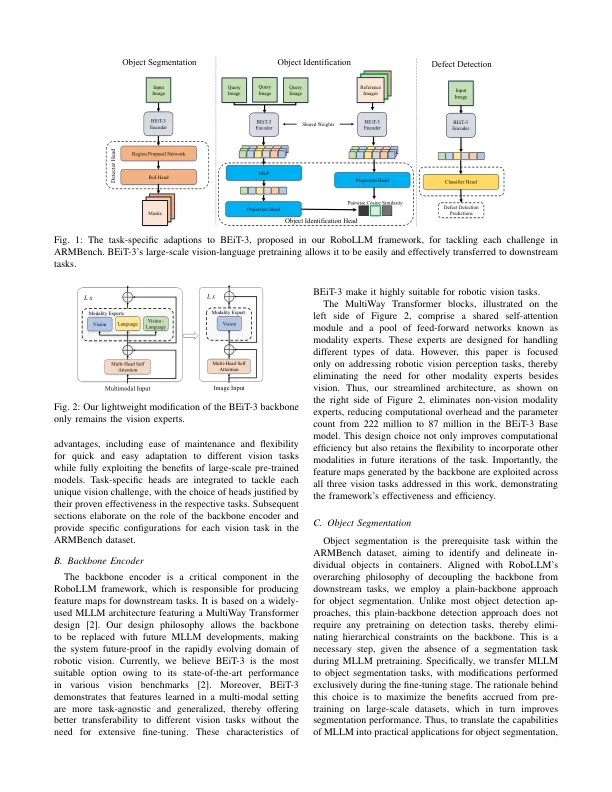

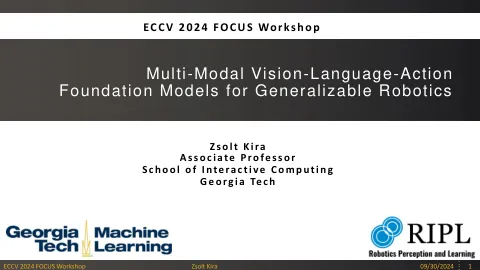

摘要 - 机器人视觉应用通常需要广泛的视觉感知任务,例如对象检测,分割和识别。尽管这些单独的任务已经取得了重大进展,但将规定的模型整合到统一的视觉管道中带来了重大的工程挑战和成本。最近,多模式大语言模型(MLLM)已成为各种下游任务的新型骨干。我们认为,利用MLLM的预训练能力可以创建简化的框架,从而减轻对特定于任务的编码器的需求。具体来说,MLLM中的大规模预认证的知识可以更轻松地对下游机器人视觉任务进行微调,并产生出色的性能。我们介绍了配备BEIT-3骨干的Robollm框架,以解决Armbench Challenge中的所有视觉感知任务,这是一个大规模的机器人操纵数据集,涉及有关Real-World Warehouse场景的大规模机器人操作数据集。Robollm不仅胜过现有的基线,而且还大大减轻了与模型选择和调整相关的工程负担。本文中使用的所有代码都可以在https://github.com/longkukuhi/armbench中找到。

Robollm:基于多模式大语言模型的机器人视觉任务

主要关键词