机构名称:

¥ 1.0

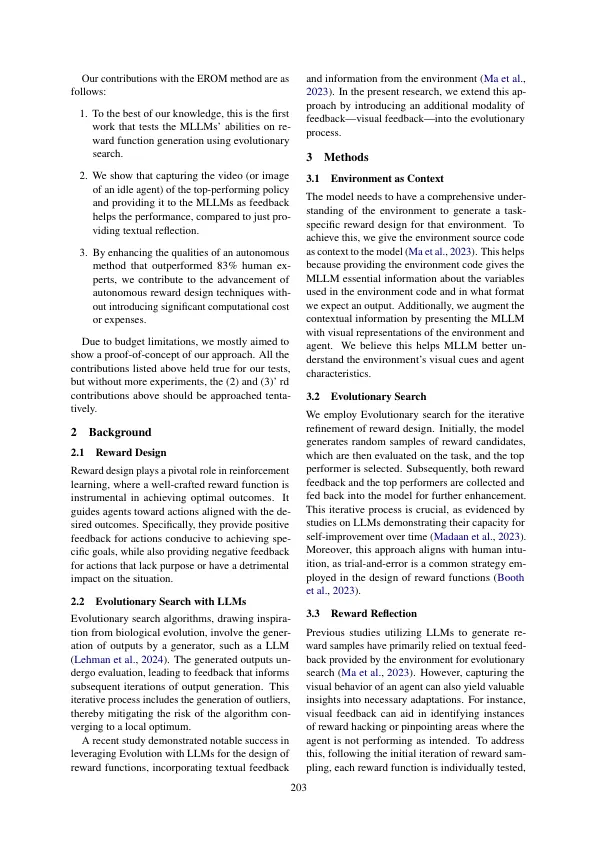

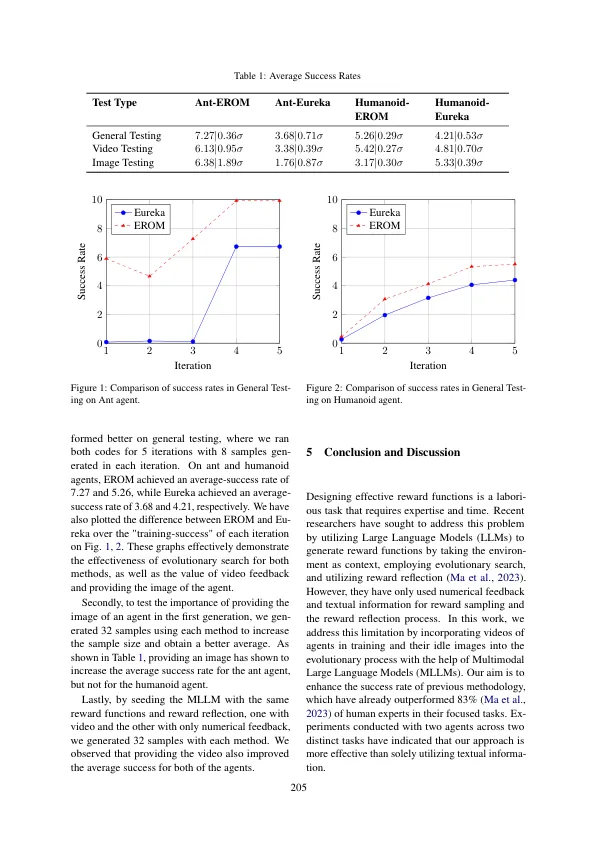

设计奖励功能是强化学习(RL)实践的关键但具有挑战性的任务,通常要求领域的努力和实质性的努力。最近的研究探索了大型语言模型(LLMS)通过进化搜索技术生成奖励功能的利用(Ma等人,2023)。但是,这些方法忽略了多模式信息的潜力,例如图像和视频。尤其是先前的方法主要依赖于RL环境中的数值反馈来进行进化,忽略了训练过程中所遵循的视觉数据。这项研究通过采用多模式的大语言模型(MLLM)来制作针对各种RL任务量身定制的重新功能,从而引入了一种新颖的方法。该方法涉及向MLLM提供RL环境代码以及其图像作为上下文和任务信息,以奖励候选人。然后,所选代理人接受培训,并作为对MLLM的反馈提供了来自环境的数值反馈以及最佳策略的记录视频。通过通过进化搜索采用迭代反馈机制,MLLM始终完善奖励函数以最大程度地提高准确性。对两种不同的代理进行测试指出了我们的方法比以前的方法相比,这本身超过了83%(Ma等人,2023)由人类专家设计的奖励功能。

使用多模式大语言模型的进化奖励设计和优化

主要关键词